请注意

本项目翻译自 《Physically Based Rendering:From Theory To Implementation》(4ed)

原文作者:Matt Pharr, Wenzel Jakob, and Greg Humphreys

原文链接:pbr-book.org

版权归原作者所有,翻译仅供学习和交流,禁止用于商业用途。

本项目初期使用机翻+人工校对整理,仅供参考学习。

出于时间原因,更新会比较慢。

为方便对照学习,每章的标题都加了跳转原文的链接。

Contents 目录

- Preface 前言

- 1 Introduction 引言

- 1.1 Literate Programming 文艺编程

- 1.2 Photorealistic Rendering and the Ray-Tracing Algorithm 照片级真实感渲染与光线追踪算法

- 1.3 pbrt: System Overview pbrt:系统概述

- 1.4 How to Proceed through This Book 如何阅读本书

- 1.5 Using and Understanding the Code 使用和理解代码

- 1.6 A Brief History of Physically Based Rendering 基于物理的渲染简史

- Further Reading 延伸阅读

- Exercises 练习

- 2 Monte Carlo Integration 蒙特卡罗积分

- 3 Geometry and Transformations 几何与变换

- 4 Radiometry, Spectra, and Color 辐射度量学、光谱与颜色

前言(Preface)

请注意

出于时间原因,前言章节尚未人工校对,还请谅解。

可以点击英文标题跳转至原文。

[ 正如 ]其他信息应该对那些想要学习和理解的人开放,程序源代码是程序员向前辈学习艺术的唯一途径。剧作家不允许其他剧作家阅读他们的剧本[或在剧院演出时]不允许他们甚至做笔记,这简直不可想象。同样,任何优秀的作者都是博览群书的,因为每个学习写作的孩子阅读的次数都比写作多出数百倍。然而,程序员却被期望独自发明字母表并学习写长篇小说。编程无法成长和学习,除非下一代程序员能够接触到前辈程序员所积累的知识和信息。 —埃里克·纳古姆(Erik Naggum)

渲染是计算机图形学的一个基本组成部分。在最高抽象层次上,渲染是将三维场景的描述转换为图像的过程。动画、几何建模、纹理处理以及计算机图形学其他领域的算法都必须通过某种渲染过程来输出结果,以便在图像中可见。渲染已变得无处不在;从电影到游戏及其他领域,它为创造性表达、娱乐和可视化开辟了新的前沿。

在该领域的早期,渲染研究主要集中在解决基本问题,例如确定从给定视点可见的对象。随着这些问题的有效解决方案的出现,以及由于其他图形领域的持续进展而提供了更丰富和更真实的场景描述,现代渲染已经开始吸收来自广泛学科的思想,包括物理学和天体物理学、天文学、生物学、心理学和感知研究,以及纯数学和应用数学。渲染的跨学科特性是其成为一个如此迷人研究领域的原因之一。

本书通过完整渲染系统的文档源代码展示了一系列现代渲染算法。本书中的几乎所有图像,包括封面上的图像,都是由该软件渲染的。生成这些图像的所有算法都在这些页面中进行了描述。该系统 pbrt 是使用一种称为 文艺编程(literate programming) 的编程方法编写的,该方法将描述系统的散文与实现它的源代码混合在一起。我们相信,文献编程方法是介绍计算机图形学和计算机科学一般思想的有价值方式。通常,算法的一些细微之处在实现之前可能不清晰或隐藏,因此查看实际实现是深入理解该算法细节的好方法。实际上,我们认为以这种方式深入理解一些精心挑选的算法比对许多算法的肤浅理解提供了更好的计算机图形学进一步研究的基础。

除了阐明算法在实践中的实现方式之外,在完整且非平凡的软件系统的背景下呈现这些算法还使我们能够解决中型渲染系统设计和实现中的问题。渲染系统基本抽象和接口的设计对实现的优雅性和后续扩展能力有着重要影响,但在这个设计空间中的权衡很少被讨论。

pbrt 和本书的内容专注于 照片级真实感渲染(photorealistic rendering),这可以被定义为生成与相机在照片中捕捉到的图像无法区分的图像,或者生成能够引发人类观察者与实际场景相同反应的图像。有许多理由专注于照片级真实感。照片级真实感图像对于电影中的特效至关重要,因为计算机生成的图像通常必须与真实世界的镜头无缝混合。在计算机游戏等所有图像都是合成的应用中,照片级真实感是让观察者忘记他们正在看一个实际上不存在的环境的有效工具。最后,照片级真实感为评估渲染系统输出质量提供了一个相对明确的标准。

读者(Audience)

本书主要面向三类读者群体。第一类是研究生或高年级本科生的计算机图形学课程学生。本书假设读者具备大学入门级课程的计算机图形学基础知识,尽管某些关键概念,如基本向量几何和变换将在此进行回顾。对于没有接触过数万行源代码程序的学生,文献编程风格提供了一个温和的引导,帮助他们理解这种复杂性。我们特别关注解释系统中一些关键接口和抽象背后的推理,以便让这些读者理解系统为何以这种方式构建。

第二个受众是计算机图形学的高级研究生和研究人员。对于那些从事渲染研究的人来说,这本书提供了该领域的广泛介绍,而 pbrt 源代码提供了一个可以用作基础的框架(或者至少可以使用一些源代码)。对于在计算机图形学其他领域工作的人,我们相信对渲染的透彻理解可以提供有用的背景。

我们的最终受众是行业中的软件开发人员。尽管本书中的许多基本概念对该受众来说是熟悉的,但以文艺风格呈现的算法解释可能会带来新的视角。 pbrt 还包括许多经过精心设计和调试的算法实现,这些算法的正确实现可能具有挑战性;这些内容对渲染领域的经验丰富的从业者尤其具有吸引力。我们希望深入探讨一个完整且非平凡的渲染系统的特定组织形式,也能引发该受众的思考。

概述与目标(Overview and Goals)

pbrt 基于光线追踪(ray-tracing)算法。光线追踪是一种优雅的技术,其起源于镜头制造;卡尔·弗里德里希·高斯在 19 世纪手动追踪光线通过镜头。计算机上的光线追踪算法沿着微小光线在场景中的路径,直到它们与表面相交。这种方法提供了一种简单的方法来找到从任何特定位置和方向看到的第一个可见物体,并且是许多渲染算法的基础。

pbrt 的设计和实现有三个主要目标:它应该是 完整的(complete),它应该是 具有示范性的(illustrative),并且它应该是 基于物理的(physically based)。

完整性意味着系统不应缺少高质量商业渲染系统中的关键特性。特别是,这意味着重要的实际问题,如抗锯齿、稳健性、数值精度以及高效渲染复杂场景的能力,都应得到充分解决。考虑这些问题在系统设计的初期阶段非常重要,因为这些特性可能对系统的所有组件产生微妙的影响,并且在后期实施阶段很难将其重新集成到系统中。

我们的第二个目标意味着我们尽量选择算法、数据结构和渲染技术时要谨慎,并关注可读性和清晰度。由于它们的实现将被比其他渲染系统更多的读者审查,我们努力选择我们所知道的最优雅的算法,并尽可能地实现它们。这个目标还要求系统足够小,以便一个人能够完全理解。我们使用可扩展架构实现了 pbrt ,系统的核心是通过一组精心设计的接口类来实现的,尽可能多的具体功能则在这些接口的实现中完成。结果是,理解系统的基本结构并不需要了解所有具体的实现。这使得深入研究感兴趣的部分变得更容易,而跳过其他部分时也不会失去对整体系统如何结合在一起的理解。

在完整性和示范性这两个目标之间存在一种紧张关系。实现和描述每一种可能的有用技术不仅会使这本书变得过于冗长,还会使系统对大多数读者来说变得过于复杂。在 pbrt 缺乏特别有用的功能的情况下,我们尝试设计架构,以便可以在不改变整体系统设计的情况下添加该功能。

物理基础渲染的基本基础是物理定律及其数学表达。 pbrt 旨在使用正确的物理单位和概念来计算其计算的量和实现的算法。 pbrt 努力计算出 物理上正确(physically correct) 的图像;它们准确反映了场景在现实世界中的照明情况。†(当然,任何计算机物理模拟都需要仔细选择适应于需求且高效计算的方式,可以阅读第 1.2 节中关于 pbrt 做出的选择的进一步讨论。) 选择使用物理基础的一个优点是,它为程序的正确性提供了一个具体的标准:对于简单场景,当期望结果可以以封闭形式计算时,如果 pbrt 没有计算出相同的结果,我们就知道实现中一定存在错误。同样,如果 pbrt 中不同的物理基础照明算法对同一场景给出了不同的结果,或者如果 pbrt 与另一个物理基础渲染器的结果不相同,那么其中肯定存在一个错误。最后,我们相信这种基于物理的渲染方法是有价值的,因为它是严谨的。 当不清楚特定计算应如何进行时,物理学提供了一个答案,以确保结果的一致性。

效率的优先级低于这三个目标。由于渲染系统在生成图像的过程中通常会运行数分钟或数小时,因此效率显然很重要。然而,我们主要关注算法效率,而不是低级代码优化。在某些情况下,明显的微优化让位于清晰、结构良好的代码,尽管我们确实努力优化了系统中大部分计算发生的部分。

在展示 pbrt 并讨论其实施过程中,我们希望传达一些经过多年研究和开发所学到的宝贵经验。编写一个好的渲染器不仅仅是将一组快速算法串联在一起;使系统既灵活又稳健是一项艰巨的任务。随着更多几何体或光源的添加,或任何其他复杂性轴的压力,系统的性能必须优雅地下降。

开发一个解决所有这些问题的系统所带来的回报是巨大的——编写一个新的渲染器或向现有渲染器添加新功能,并利用它创建以前无法生成的图像是一种极大的乐趣。我们编写本书的最根本目标是将这一机会带给更广泛的受众。鼓励读者在阅读本书的过程中使用该系统渲染 pbrt 软件分发中的示例场景。每章末尾的练习建议对系统进行修改,以帮助澄清其内部工作原理,并提出更复杂的项目,通过添加新功能来扩展系统。

本书的网站位于 pbrt.org。该网站包含指向 pbrt 源代码的链接、可以下载以使用 pbrt 渲染的场景,以及错误跟踪器和勘误表。任何未在勘误表中列出的文本错误可以报告至电子邮件地址 authors@pbrt.org。我们非常重视您的反馈!

第一版与第二版之间的变化(Changes Between The First and Second Editions)

自 2004 年本书第一版出版到 2010 年第二版出版之间过去了六年。在这段时间里,书籍售出了数千本,并且 pbrt 软件在书籍网站上被下载了数千次。 pbrt 用户群体给了我们大量的反馈和鼓励,我们在系统上的经验指导了我们在第一版和第二版之间进行更改时所做的许多决策。除了若干错误修复外,我们还进行了几项重要的设计更改和增强:

- 移除插件架构(Removal of the plugin architecture): pbrt 的第一个版本使用了运行时插件架构,以动态加载用于当前渲染场景中的对象(如形状、光源、积分器、相机和其他对象)的实现代码。这种方法允许用户在不重新编译整个渲染系统的情况下,使用新对象类型(例如,新形状原语)扩展 pbrt 。这种方法最初看起来很优雅,但它使得在多个平台上支持 pbrt 的任务变得复杂,并且使调试变得更加困难。它真正启用的唯一新使用场景(仅二进制分发的 pbrt 或二进制插件)实际上与我们的教学和开源目标相悖。因此,在本版中放弃了插件架构。

- 移除图像处理管道(Removal of the image-processing pipeline): pbrt 的第一个版本提供了一个色调映射接口,将高动态范围(HDR)浮点输出图像直接转换为低动态范围 TIFF 以供显示。这个功能在 2004 年是有意义的,因为对 HDR 图像的支持仍然稀少。然而,到 2010 年,数字摄影的进步使得 HDR 图像变得普遍。尽管色调映射的理论和实践优雅且值得学习,我们决定将新书的重点完全放在图像形成的过程上,跳过图像显示的主题。感兴趣的读者应参考 Reinhard 等人(2010)撰写的书籍,以获得对 HDR 图像显示过程的全面和现代的处理。

- 任务并行性(Task parallelism): 多核架构变得无处不在,我们认为 pbrt 如果不能扩展到本地可用核心的数量,将不会保持相关性。我们也希望本书中记录的并行编程实现细节能够帮助图形程序员理解编写可扩展并行代码的一些细微差别和复杂性。

- “生产”渲染的适用性(Appropriateness for “production” rendering): pbrt 的第一个版本仅作为教学工具和渲染研究的跳板。实际上,我们在准备第一版时做出了一些与生产环境使用相悖的决策,例如对基于图像的光照支持有限、不支持运动模糊,以及在复杂光照下不够稳健的光子映射实现。随着对这些特性的支持大幅改善,以及对次表面散射和梅特罗波利斯光传输的支持,我们认为在第二版中, pbrt 变得更加适合渲染复杂环境的高质量图像。

第二版与第三版之间的变化(Changes Between The Second and Third Editions)

随着又六年的过去,是时候更新和扩展这本书以及 pbrt 系统了。我们继续从读者和用户的经验中学习,以更好地理解哪些主题最有用。此外,研究的进展也在持续进行;书中的许多部分需要更新,以反映当前的最佳实践。我们在多个方面进行了显著改进:

- 双向光传输(Bidirectional light transport): pbrt 的第三个版本增加了一个双向路径追踪器,包括对体积光传输的全面支持和多重重要性采样以加权路径。全新的大都会光传输积分器使用了双向路径追踪器的组件,从而实现了该算法的特别简洁的实现。

- 次表面散射(Subsurface scattering): 许多物体的外观——特别是皮肤和半透明物体——是次表面光传输的结果。我们在第二版中实现的次表面散射反映了 2000 年代初的最新技术;我们彻底更新了 BSSRDF 模型和我们的次表面光传输算法,以反映在随后的十年研究中取得的进展。

- 数值稳健的交点(Numerically robust intersections): 浮点舍入误差在几何光线交点计算中的影响一直是光线追踪中的一个长期挑战:它们可能导致图像中存在小误差。我们专注于这个问题,并推导出了这种误差的保守(但紧密)界限,这使我们的实现比以前的渲染系统对这个问题更具稳健性。

- 参与介质表示(Participating media representation): 我们显著改善了系统中散射媒体的描述和表示方式;这使得在嵌套散射媒体中获得更准确的结果成为可能。一种新的采样技术实现了对异质媒体的无偏渲染,并与系统的其他部分干净地集成。

- 测量材质(Measured materials): 本版新增了一种使用稀疏频率空间基表示和评估测量材料的新技术。这种方法方便,因为它允许进行精确的重要性采样,而这是在上一版中使用的表示方法所无法实现的。

- 光子映射(Photon mapping): 光子映射算法的一项重要进展是开发了不需要在内存中存储所有光子的变体。我们用基于随机渐进光子映射的实现替换了 pbrt 的光子映射算法,该算法有效地渲染了许多复杂的光传输效果。

- 样本生成算法(Sample generation algorithms): 用于渲染算法中数值积分的样本值分布对最终结果的质量可能产生意想不到的重大影响。我们对该主题进行了全面更新,深入探讨了新方法和高效实现技术。

系统的许多其他部分得到了改进和更新,以反映该领域的进展:微面反射模型得到了更深入的处理,采样技术大大提高;新增了一种“曲线”形状,用于建模头发和其他精细几何体;并且提供了一种新的相机模型,模拟真实的镜头系统。在整本书中,我们进行了许多较小的更改,以更清晰地解释和说明物理基础渲染系统中的关键概念,如 pbrt 。

第三版与第四版之间的变化(Changes Between The Third and Fourth Editions)

渲染算法的创新没有减缓的迹象,因此在 2019 年我们开始专注于第四版的工作。几乎每一章都包含了大量的新增内容,我们还更新了章节和引入思想的顺序,将蒙特卡罗积分和路径追踪的基本思想放在了前面,而不是留到最后。

系统中特别显著改进的能力包括:

- 体积散射(Volumetric scattering): 我们已将参与介质散射的算法更新至最新水平,增加了对发射体积的支持、高效采样具有不同密度的体积,以及对色散介质的强大支持,其中散射特性随波长变化。

- 光谱渲染(Spectral rendering): 我们已剔除所有用于照明计算的 RGB 颜色; pbrt 现在仅根据波长依赖的光谱分布样本进行照明计算。这种方法不仅比使用 RGB 更具物理准确性,还允许 pbrt 准确模拟色散等效果。

- 反射模型(Reflection models): 我们对 BSDF 基础和反射模型的覆盖进行了广泛修订,并扩展了所涵盖的 BSDF 范围,包括一种准确模拟头发反射的模型和另一种模拟分层材料散射的模型。测量的 BRDF 采用了一种新方法,可以表示广泛材料的反射光谱。

- 光采样(Light sampling): 我们不仅改进了单个光源上采样点的算法,以更好地反映最新技术,这一版本还支持 多光源采样(many-light sampling),使得通过仔细采样少量光源来高效渲染具有成千上万或数百万光源的场景成为可能。

- GPU 渲染(GPU rendering): 此版本的 pbrt 增加了对 GPU 渲染的支持,GPU 的光线追踪性能比 CPU 高出 10 到 100 倍。我们以一种方式实现了这一功能,使书中几乎所有的代码都可以在 CPU 和 GPU 上运行,这使得将与 GPU 相关的问题的讨论局限于第 15 章成为可能。

该系统还进行了许多其他改进和新增功能,包括新的双线性补丁形状,对蒙特卡洛积分核心的样本生成算法进行了多次更新,支持在每个像素输出关于可见表面几何和反射属性的辅助信息,以及对系统的许多其他小改进。

致谢(Acknowledgments)

帕特·汉拉汉为本书的贡献超出了我们所能承认的范围;我们对他深感感激。他不懈地主张使用干净的接口和找到合适的抽象来贯穿整个系统,他对渲染的理解和方法深刻影响了其设计。他愿意在斯坦福的渲染课程中使用 pbrt 和这份手稿,对其早期发展阶段尤其有帮助,当时它仍处于非常粗糙的状态;他在整个过程中提供的反馈对将文本带到目前的状态至关重要。最后,帕特在斯坦福图形实验室帮助组建的团队,以及他所营造的开放环境,创造了一个令人兴奋、刺激和富有成效的氛围。马特和格雷格都感到非常荣幸能够参与其中。

我们要感谢许多在 1999 年至 2004 年间在斯坦福大学和维吉尼亚大学课程中使用本书早期草稿的学生。这些学生提供了大量关于本书的反馈和 pbrt 。这些课程的助教值得特别提及:斯坦福的 Tim Purcell、Mike Cammarano、Ian Buck 和 Ren Ng,以及维吉尼亚的 Nolan Goodnight。那些班级中的一些学生提供了特别有价值的反馈,并发送了错误报告和修复;我们特别感谢 Evan Parker 和 Phil Beatty。本书的手稿草稿在德克萨斯大学奥斯汀分校的 Bill Mark 和 Don Fussell 教授的课程中使用,以及在俄亥俄州立大学的 Raghu Machiraju 教授的课程中使用;他们的反馈是无价的,我们感谢他们在课程中大胆地融入这个系统,即使在它仍在编辑和修订的过程中。

马特·法尔想要感谢在渲染相关工作中给予他极大教育支持的同事和合作伙伴,他们对他编写渲染器的方法和对该领域的理解产生了重要影响。特别感谢克雷格·科尔布,他通过公开的 rayshade 光线追踪系统源代码为马特早期的计算机图形教育奠定了基础;以及埃里克·维奇,他也慷慨地提供了时间和专业知识。还要感谢道格·舒尔特和斯坦·艾森斯塔特,在高中和大学期间分别给予的数学和计算机科学的基础课程,最重要的是感谢马特的父母,感谢他们提供的教育和一路上的持续鼓励。最后,感谢 NVIDIA 支持本书第一版和最新版本的准备;在 NVIDIA,感谢尼克·特里安托斯和贾扬特·科尔赫在第一版准备的最后阶段给予的支持,以及感谢亚伦·莱丰、戴维·卢布基和比尔·达利对第四版工作的支持。

格雷格·汉弗莱斯非常感谢所有在他普林斯顿大学本科期间容忍他的教授和助教。许多人鼓励他对图形的兴趣,特别是迈克尔·科恩、大卫·多布金、亚当·芬克尔斯坦、迈克尔·考克斯、戈登·斯托尔、帕特里克·敏和丹·沃拉赫。道格·克拉克、史蒂夫·莱昂和安迪·沃尔夫也监督了各种独立研究项目,甚至没有笑一次。一次,在关于一个为期一年的机器人项目的组会上,史蒂夫·莱昂变得恼火,喊道:“别告诉我为什么做不到,想办法怎么做!”——这是一堂永远不会被遗忘的即兴课。埃里克·里斯塔德在格雷格大一结束后(甚至在夏天开始之前)解雇了他作为暑期研究助理,把他推给了毫无防备的帕特·汉拉汉,开始了一段跨越 10 年和两个海岸的指导关系。最后,戴夫·汉森教会格雷格,文艺编程是一种很好的工作方式,计算机编程可以是一种美丽而微妙的艺术形式。

温泽尔·雅各布在 2004 年本科期间收到第一版 pbrt 时感到非常兴奋。毫无疑问,这对他的职业生涯产生了深远的影响——因此,温泽尔想首先感谢他的合著者邀请他成为本书第三版和第四版的一部分。温泽尔非常感激史蒂夫·马斯切尔,他在康奈尔大学的五年博士生涯中担任了他的导师。史蒂夫将他带入了研究的世界,并始终是他灵感的源泉。温泽尔还感谢图形组其他成员的指导和创造的激励研究环境,包括卡维塔·巴拉、道格·詹姆斯和布鲁斯·沃尔特。温泽尔与奥尔加·索尔基娜·霍尔农度过了美好的博士后时光,她向他介绍了几何处理。温泽尔非常感激奥尔加对他参与本书第三版的支持。

我们特别感谢那些完整阅读了草稿的评审;他们在手稿不同阶段提供了深刻而建设性的反馈。感谢 Ian Ashdown、Per Christensen、Doug Epps、Dan Goldman、Eric Haines、Erik Reinhard、Pete Shirley、Peter-Pike Sloan、Greg Ward 以及一众匿名评审对书籍第一版和第二版的反馈。对于第二版,感谢 Janne Kontkanen、Bill Mark、Nelson Max 和 Eric Tabellion。对于第四版,我们感谢 Thomas Müller 和 Per Christensen,他们都提供了大量反馈,显著改善了最终版本。

许多专家友好地向我们解释了他们工作中的细微差别,并指导我们最佳实践。对于第一版和第二版,我们还要感谢唐·米切尔,他帮助我们理解了一些采样和重建的细节;托马斯·科利格和亚历山大·凯勒,解释了低差异采样的细微之处;克里斯特·埃里克森,他对改进我们的 kd 树实现提出了一些建议;以及克里斯托夫·赫里和尤金·德昂,帮助我们理解了次表面散射的细微差别。

在第三版中,我们特别感谢 Leo Grünschloß对我们采样章节的审阅;感谢 Alexander Keller 对该章节主题的建议;感谢 Eric Heitz 在微面和我们关于该主题的文本审阅方面提供的广泛帮助;感谢 Thiago Ize 对浮点错误文本的全面审阅;感谢 Tom van Bussel 报告我们 BSSRDF 代码中的多个错误;感谢 Ralf Habel 审阅我们的 BSSRDF 文本;以及感谢 Toshiya Hachisuka 和 Anton Kaplanyan 对我们光传输章节的广泛审阅和评论。

在第四版中,感谢 Alejandro Conty Estevez 对我们多光采样处理的审阅;感谢 Eugene d’Eon、Bailey Miller 和 Jan Novák 对体积散射章节的评论;感谢 Eric Haines、Simon Kallweit、Martin Stich 和 Carsten Wächter 对 GPU 渲染章节的审阅;感谢 Karl Li 对多个章节的反馈;感谢 Tzu-Mao Li 对我们关于逆向和可微渲染讨论的审阅;感谢 Fabrice Rousselle 对机器学习和渲染的反馈;感谢 Gurprit Singh 对我们关于蒙特卡罗积分的傅里叶分析讨论的评论。我们还感谢 Jeppe Revall Frisvad 对 pbrt 在前几版中反射模型处理的广泛评论和建议。

对于本版本中对 pbrt 实现的改进,感谢 Pierre Moreau 在调试 pbrt 在 Windows 上的 GPU 支持方面所做的努力,以及 Jim Price,他不仅发现并修复了 pbrt 源代码早期版本中的众多错误,还贡献了比我们原始实现更好的色彩体积媒体表示。我们还非常感谢 Weta Digital 的 Anders Langlands 和 Luca Fascione 提供的 PhysLight 系统实现,该实现已被纳入 pbrt 的 PixelSensor 类和光源实现中。

许多人报告了之前版本文本中的错误或 pbrt 中的漏洞。我们特别感谢 Solomon Boulos、Stephen Chenney、Per Christensen、John Danks、Mike Day、Kevin Egan、Volodymyr Kachurovskyi、Kostya Smolenskiy、Ke Xu 和 Arek Zimny,他们的贡献尤其丰硕。

对于他们的建议和错误报告,我们还要感谢 Rachit Agrawal、Frederick Akalin、Thomas de Bodt、Mark Bolstad、Brian Budge、Jonathon Cai、Bryan Catanzaro、Tzu-Chieh Chang、Mark Colbert、Yunjian Ding、Tao Du、Marcos Fajardo、Shaohua Fan、Luca Fascione、Etienne Ferrier、Nigel Fisher、Jeppe Revall Frisvad、Robert G. Graf、Asbjørn Heid、Steve Hill、Wei-Feng Huang、John “Spike” Hughes、Keith Jeffery、Greg Johnson、Aaron Karp、Andrew Kensler、Alan King、Donald Knuth、Martin Kraus、Chris Kulla、Murat Kurt、Larry Lai、Morgan McGuire、Craig McNaughton、Don Mitchell、Swaminathan Narayanan、Anders Nilsson、Jens Olsson、Vincent Pegoraro、Srinath Ravichandiran、Andy Selle、Sébastien Speierer、Nils Thuerey、Eric Veach、Ingo Wald、Zejian Wang、Xiong Wei、Wei-Wei Xu、Tizian Zeltner 和 Matthias Zwicker。最后,我们要感谢 LuxRender 开发者和 LuxRender 社区,特别是 Terrence Vergauwen、Jean-Philippe Grimaldi 和 Asbjørn Heid;看到他们从 pbrt 的基础上构建的渲染系统令人愉快,我们从阅读他们的源代码和新渲染算法的实现中学到了很多。

特别感谢 Framestore 的 Martin Preston 和 Steph Bruning,感谢他们帮助我们使用 《地心引力》(Gravity) 的一个画面(图片由华纳兄弟和 Framestore 提供),以及 Weta Digital 对 《阿丽塔:战斗天使》(Alita: Battle Angel) 画面的支持(© 2018 二十世纪福克斯电影公司,版权所有)。

生产(Production)

在第一版的制作过程中,我们还要感谢我们的编辑 Tim Cox,感谢他愿意承担这个稍显不寻常的项目,以及在整个过程中给予的指导和耐心。我们非常感谢项目经理 Elisabeth Beller,她在书籍制作中超出了职责范围;她能够将这个复杂的项目控制在轨道上并按时完成,令人赞叹,我们特别感谢她对最终结果质量的显著影响。还要感谢 Rick Camp(编辑助理)在整个过程中所做的许多贡献。Windfall Software 的 Paul Anagnostopoulos 和 Jacqui Scarlott 负责了书籍的排版;他们能够将作者的自制文献编程文件格式转化为高质量的最终输出,同时还处理我们要求的多种不寻常的索引类型,令人非常感激。还要感谢 Ken DellaPenta(校对编辑)和 Jennifer McClain(校对员),以及 Chen Design 的 Max Spector(文本和封面设计师)和 Steve Rath(索引员)。

在第二版中,我们要感谢 Greg Chalson,他说服我们扩展和更新这本书;Greg 还确保 Windfall Software 的 Paul Anagnostopoulos 再次负责本书的排版。我们要再次感谢 Paul 在处理本书的制作复杂性方面所做的努力。最后,我们还要感谢 Elsevier 的 Todd Green、Paul Gottehrer 和 Heather Scherer。

在第三版中,我们要感谢托德·格林,他负责了这一轮的工作,以及艾米·因弗内齐,她在整个过程中保持了进度。我们很高兴保罗·阿纳格诺斯托普洛斯再次参与了这一过程;他的努力对本书的高制作价值至关重要,这对我们来说非常重要。

第四版让我们转向了麻省理工学院出版社;非常感谢 Elizabeth Swayze 对我们加入的热情、在制作过程中的指导,以及确保 Paul Anagnostopoulos 再次负责排版。我们对 Paul 再次与我们合作一版表示最深切的感谢,同时也非常感谢 MaryEllen Oliver 在校对和编辑方面的出色工作。

在线版(The Online Edition)

截至 2023 年 11 月 1 日,第四版的完整文本已在线免费提供。非常感谢麻省理工学院出版社和伊丽莎白·斯威兹对该书免费版本的支持。

许多开源系统对 基于物理的渲染(Physically Based Rendering) 在线版本的开发起到了重要作用。我们特别感谢 Bootstrap、JERI、MathJax 和 JQuery 的开发者。我们还要感谢 Impallari Type 设计的用于正文的 Domine 字体;Christian Robertson 设计的用于代码的 Roboto Mono 字体;以及 Font Awesome 字体的设计者。

我们还要感谢所有通过 Patreon 支持早期在线版的人;截至 2023 年 11 月 1 日:3Dscan、Abdelhakim Deneche、Alain Galvan、Andréa Machizaud、Aras Pranckevicius、Arman Uguray、Ben Bass、Claudia Doppioslash、Dong Feng、Enrico、Filip Strugar、Haralambi Todorov、Jaewon Jung、Jan Walter、Jendrik Illner、Jim Price、Joakim Dahl、Jonathan Stone、KrotanHill、Laura Reznikov、Malte Nawroth、Mauricio Vives、Mrinal Deo、Nathan Vegdahl、Pavel Panchekha、Pratool Gadtaula、Saad Ahmed、Scott Pilet、Shin Watanabe、Steve Watts Kennedy、Tom Hulton-Harrop、Torgrim Boe Skaarsmoen、William Newhall、Yining Karl Li 和 Yury Mikhaylov。然而,随着第四版的发布,我们已关闭了 Patreon。

尽管这本书在线发布,供任何人免费阅读,但书籍的文本仍然受© 版权保护,版权归 2004–2023 年 Matt Pharr、Wenzel Jakob 和 Greg Humphreys 所有,采用 CC BY-NC-ND 4.0 许可证。书中的图形采用 CC BY-NC-SA 4.0 许可证,认为它们在教授图形课程时可能会有用。

场景、模型和数据(Scenes, Models, and Data)

许多人和组织慷慨地提供了本书和 pbrt 发行中使用的场景和模型。他们的慷慨对我们在整个文本中创建有趣的示例图像帮助巨大。

我们非常感谢 Evolución Visual 的 Guillermo M. Leal Llaguno,www.evvisual.com,他为第二版封面上展示的标志性 圣米格尔场景(San Miguel) 进行了建模和渲染,并且该场景仍在书中的多个图形中使用。我们还特别感谢 Marko Dabrovic(www.3lhd.com)和 RNA Studios 的 Mihovil Odak(www.rna.hr),他们提供了大量在书的早期版本中使用的模型和场景,包括 Sponza 中庭、斯 ibenik 大教堂以及在本版的图 16.1 中可以看到的 Audi TT 汽车模型。我们还要特别感谢 Florent Boyer,他提供了在第 chap:bidir-methods 章中某些图像中使用的现代住宅场景。

我们衷心感谢 Laubwerk 的 Jan-Walter Schliep、Burak Kahraman 和 Timm Dapper(www.laubwerk.com)为本书前一版封面上展示的 乡村(Countryside ) 景观场景的创作,并在本版的多个图形中使用。

非常感谢 Lucydreams 的 Angelo Ferretti(www.lucydreams.it)授权使用 Watercolor 和 Kroken 场景,这为本版提供了精彩的封面图像、众多图形的素材,以及一对复杂的场景,展示了 pbrt 的能力。

吉姆·普赖斯友好地提供了一些包含有趣体积媒体的场景;这些场景显著改善了该主题的数据。还要感谢 Beeple 以宽松许可提供 《零日》(Zero Day) 和 《透明机器》(Transparent Machines) 场景,以及马丁·卢比奇提供的奥地利帝国皇冠模型。最后,衷心感谢华特迪士尼动画工作室提供的制作复杂度 《莫阿娜岛》(Moana Island) 场景,以及提供的详细体积云模型。

兔子、佛陀和龙模型由斯坦福计算机图形实验室的扫描库提供。“killeroo”模型经 Phil Dench 和 Martin Rezard 许可使用(3D 扫描和数字表现由 headus 提供,设计和粘土雕塑由 Rezard 完成)。第 9 章中使用的龙模型扫描由 Christian Schüller 提供,感谢 Yasutoshi Mori 提供的材料球和跑车模型。用于说明第 chap:bidir-methods 章中的光学现象的玻璃由 Simon Wendsche 提供。用于说明次表面散射的头部模型由 Infinite Realities, Inc.根据创意共享署名 3.0 许可证提供。还要感谢“暴君猴子”提供的 BMW M6 汽车模型和“Wig42”提供的早餐桌场景;这两者均在 blendswap.com 上发布,也是在创意共享署名 3.0 许可证下。

我们使用了来自 PolyHaven 网站(polyhaven.com)的多个环境贴图用于各种场景的 HDR 照明;所有贴图均在创意共享 CC0 许可证下提供。感谢 Sergej Majboroda 和 Greg Zaal,我们使用了他们的环境贴图。

马克·埃伦斯提供了多种光源的光谱数据,而多种显示器的光谱 RGB 测量数据由 X-Rite 的汤姆·利安扎提供。我们还要感谢丹尼·帕斯卡尔(www.babelcolor.com)允许我们包含他的色卡光谱反射率测量数据。感谢米哈伊尔·波利扬斯基通过 refractiveindex.info 提供的折射率数据,以及安德斯·朗兰兹、卢卡·法乔内和 Weta Digital 提供的相机传感器响应数据,这些数据包含在 pbrt 中。

关于封面

封面上的 水彩(Watercolor) 场景由 Lucydreams 的安杰洛·费雷蒂(Angelo Ferretti)创作(www.lucydreams.it)。几何体需要总共 2 GiB 的磁盘存储,纹理贴图需要 836 MiB。在渲染时,场景描述需要 15 GiB 的内存来存储超过 3300 万个独特三角形、412 个纹理贴图和相关数据结构。

延伸阅读(Further Reading)

唐纳德·克努斯的文章 《文艺编程》(Literate Programming)(Knuth 1984)描述了文艺编程的主要思想以及他的 web 编程环境。开创性的 \( \text{T}_\text{E}\text{X} \) 排版系统是用 web 编写的,并已作为一系列书籍出版(Knuth 1986;Knuth 1993a)。克努斯和莱维展示了 cweb 文艺编程系统的实现作为一个文艺程序(Knuth and Levy 1994)。克努斯还在 《斯坦福图形库》(The Stanford GraphBase)(Knuth 1993b)中发布了一系列图算法,并发布了文艺格式的 MMIX 指令集的模拟器(Knuth 1999)。这些程序阅读起来令人愉快,并且是各自算法的优秀展示。网站 www.literateprogramming.com 提供了许多关于文艺编程的文章链接、可下载的文艺程序以及各种文艺编程系统;自克努斯最初提出这一理念以来,已经进行了许多改进。

我们知道的其他以书籍形式出版的有识字程序包括关于 lcc 编译器实现的一本书,该书由 Christopher Fraser 和 David Hanson 撰写,并以 《可重定向 C 编译器:设计与实现》(A Retargetable C Compiler: Design and Implementation)(Fraser 和 Hanson 1995)出版。另请参见 Hanson 关于程序接口设计的书(Hanson 1996)、Mehlhorn 和 Näher 关于 LEDA 库实现的演示(Mehlhorn 和 Näher 1999)、Valiente 的图算法合集(Valiente 2002)以及 Ruckert 对 mp3 音频格式的描述(Ruckert 2005)。

参考文献(References)

- Fraser, C., and D. Hanson. 1995. A Retargetable C Compiler: Design and Implementation. Reading, Massachusetts: Addison-Wesley.

- Hanson, D. R. 1996. C Interfaces and Implementations: Techniques for Creating Reusable Software. Boston, Massachusetts: Addison-Wesley Longman.

- Knuth, D. E. 1984. Literate programming. The Computer Journal 27, 97–111. Reprinted in D. E. Knuth, Literate Programming, Stanford Center for the Study of Language and - Information, 1992.

- Knuth, D. E. 1986. MetaFont: The Program. Reading, Massachusetts: Addison-Wesley.

- Knuth, D. E. 1993a. TEX : The Program. Reading, Massachusetts: Addison-Wesley.

- Knuth, D. E. 1993b. The Stanford GraphBase. New York: ACM Press and Addison-Wesley.

- Knuth, D. E. 1999. MMIXware: A RISC Computer for the Third Millennium. Berlin: Springer-Verlag.

- Knuth, D. E., and S. Levy. 1994. The CWEB System of Structured Documentation: Version 3.0. Reading, Massachusetts: Addison-Wesley.

- Mehlhorn, K., and S. Näher. 1999. LEDA: A Platform for Combinatorial and Geometric Computing. Cambridge: Cambridge University Press.

- Reinhard, E., G. Ward, P. Debevec, S. Pattanaik, W. Heidrich, and K. Myszkowski. 2010. High Dynamic Range Imaging: Acquisition, Display, and Image-Based Lighting. San Francisco: - Morgan Kaufmann.

- Ruckert, M. 2005. Understanding MP3. Wiesbaden, Germany: GWV-Vieweg.

- Valiente, G. 2002. Algorithms on Trees and Graphs, Berlin, Heidelberg: Springer-Verlag.

1 引言(Introduction)

渲染是从3D场景的描述中生成图像的过程。显然,这是一个广泛的任务,有许多不同的方法来实现它。基于物理的技术试图模拟现实,即使用物理学原理来建模光与物质的相互作用。虽然基于物理的方法似乎是实现渲染的最显而易见的方法,但它在实践中广泛应用也仅仅是在过去的15年左右。

本书介绍了基于光线追踪算法的物理化渲染系统——pbrt。它能够渲染复杂场景的逼真图像,如图1.1所示。(除了在本章中特别指出的几个例外,本书中的所有图像都是使用pbrt渲染的。)

大多数计算机图形学书籍介绍的是算法和理论,有时会结合一些代码片段。相比之下,本书将理论与一个功能齐全的渲染系统的完整实现结合在一起。此外,该系统的完整源代码可通过开源许可证获得,本书的全文也可以在线免费获取,网址为 pbr-book.org/4ed,发布日期为2023年11月1日。有关pbrt的更多信息,包括示例场景和其他相关内容,可以访问网站 pbrt.org。

图1.1:由

pbrt渲染的场景。

Kroken 场景包含复杂的几何结构、材质和光传输。在渲染系统中妥善处理所有这些效果,使得能够渲染出如图所示的逼真图像。这个场景和其他许多场景可以从pbrt网站下载。

(场景由Angelo Ferretti提供。)

1.1 文艺编程(Literate Programming)

请注意

本项目使用 Markdown 整理翻译,所以格式未遵循原文的文艺编程规范,还请谅解。

在创建 \( \text{T}_\text{E}\text{X} \) 排版系统时,唐纳德·克努斯(Donald Knuth)开发了一种基于简单但革命性思想的新编程方法论。引用克努斯的话:“让我们改变对程序构建的传统态度:与其想象我们的主要任务是指示计算机该做什么,不如集中精力向人类解释我们希望计算机做什么。”他将这种方法论称为 文艺编程(literate programming)。本书(包括您现在阅读的章节)是一个长篇文艺程序(literate program)。这意味着在阅读本书的过程中,您将阅读 pbrt 渲染系统的完整实现,而不仅仅是对它的高层次描述。

文艺程序是用一种混合文档格式语言(例如 \( \text{T}_\text{E}\text{X} \) 或 HTML)和编程语言(例如 C++)的元语言编写的。两个独立的系统处理该程序:“编织(weaver)”将可读程序转换为适合排版的文档,“解开(tangler)”生成适合编译的源代码。我们的可读编程系统是自制的,但受到诺曼·拉姆齐(Norman Ramsey)的 noweb 系统的重大影响。

文艺编程元语言提供了两个重要特性。第一个是将散文与源代码混合的能力。这个特性使得程序的描述与其实际源代码平起平坐,鼓励仔细的设计和文档编写。第二,该语言提供了以与编译器输入完全不同的顺序向读者呈现程序代码的机制。因此,程序可以以逻辑的方式进行描述。每个命名的代码块称为 片段(fragment),每个片段可以通过名称引用其他片段。

作为一个简单的例子,考虑一个函数 InitGlobals() ,它负责初始化程序的所有全局变量:†(本节的代码仅用于说明,并不是 pbrt 中的部分)

void InitGlobals() {

nMarbles = 25.7;

shoeSize = 13;

dielectric = true;

}

尽管这个函数很简短,但没有任何上下文很难理解。例如,为什么变量 nMarbles 可以取浮点值?仅仅查看代码,人们需要搜索整个程序,以查看每个变量的声明位置以及它是如何使用的,以理解其目的和合法值的含义。尽管这种系统结构对于编译器来说很好,但人类读者更希望看到每个变量的初始化代码单独呈现,靠近声明和使用该变量的代码。

在一个文艺程序中,可以这样写 InitGlobals() :

/** 函数定义 */

void InitGlobals() {

/** 初始化全局变量 */

shoeSize = 13;

dielectric = true;

}

这定义了一个片段,称为 <<函数定义>>,其中包含 InitGlobals() 函数的定义。 InitGlobals() 函数本身引用了另一个片段 <<初始化全局变量>>。由于初始化片段尚未定义,我们对这个函数一无所知,只知道它可能包含对全局变量的赋值。(不过,我们可以通过点击它右侧的加号提前查看;这样做会展开该片段的所有最终代码。)

仅仅拥有片段名称在目前是合适的抽象层次,因为尚未声明任何变量。当我们在程序的后面某处引入全局变量 shoeSize 时,我们可以写。

/** 初始化全局变量 */

shoeSize = 13;

在这里,我们开始定义 <<初始化全局变量>> 的内容。当文艺程序被编译成源代码时,文艺编程系统会在 InitGlobals() 函数的定义中替换代码 shoeSize = 13; 。等号后面的 \( \blacktriangledown \) 符号表示稍后将向该片段添加更多代码。点击它可以带您到发生该操作的地方。

在文本后面,我们可以定义另一个全局变量 dielectric ,并可以将其初始化附加到该片段中:

/** 初始化全局变量 */

dielectric = true;

在片段名称后面的 += 符号表示我们已添加到先前定义的片段。此外,\( \blacktriangle \)符号链接回之前 <<初始化全局变量>> 添加代码的地方。

当解开时,这三个片段变成代码

void InitGlobals() {

// 初始化全局变量

shoeSize = 13;

dielectric = true;

}

通过这种方式,我们可以将复杂的函数分解为逻辑上不同的部分,使它们更容易理解。例如,我们可以将一个复杂的函数写成一系列片段:

/** 函数定义 */

void complexFunc(int x, int y, double *values) {

<<Check validity of arguments>>

/** 检查参数的有效性 */

if (x < y) {

/** 交换 x 和 y */

}

/** 循环前进行预计算 */

/** 循环遍历并更新 values 数组 */

}

再次,每个片段的内容在 complexFunc() 中展开以供编译。在文档中,我们可以依次介绍每个片段及其实现。这种分解使我们能够逐行呈现代码,从而更容易理解。这种编程风格的另一个优点是,通过将功能分成逻辑片段,每个片段都有一个单一且明确的目的,每个片段都可以独立编写、验证或阅读。一般来说,我们会尽量使每个片段少于 10 行。

在某种意义上,文艺编程系统只是一个增强的宏替换包,专门用于重新排列程序源代码。这看起来可能是一个微不足道的变化,但实际上,文艺编程与其他软件系统结构化方式有很大不同。

1.2 照片级真实感渲染与光线追踪算法(Photorealistic Rendering and the Ray-Tracing Algorithm)

光真实感渲染的目标是创建一个 3D 场景的图像,使其与同一场景的照片无法区分。在我们描述渲染过程之前,重要的是要理解,在这个上下文中,无法区分 这个词并不精确,因为它涉及到人类观察者,不同的观察者可能会对同一图像有不同的感知。尽管我们将在本书中讨论一些感知问题,但考虑到特定观察者的精确特征是一个困难且尚未完全解决的问题。在大多数情况下,我们将满足于对光的物理特性及其与物质相互作用的准确模拟,依赖我们对显示技术的理解,以向观众呈现最佳图像。

鉴于对光的真实模拟的单一关注,似乎有必要问:光是什么?通过光的感知是我们存在的核心,这个简单的问题自有记录以来就占据了著名哲学家和物理学家的思维。古印度哲学学派维谢什卡(公元前 5-6 世纪)将光视为沿着光线以高速移动的小粒子的集合。在公元前 5 世纪,希腊哲学家恩培多克勒斯假设一种神圣的火焰从人眼中产生,并与来自太阳的光线结合以产生视觉。在 18 世纪和 19 世纪之间,像艾萨克·牛顿、托马斯·杨和奥古斯丁-让·弗涅尔这样的博学者支持了将光建模为波动或粒子传播结果的相互矛盾的理论。在同一时期,安德烈-玛丽·安培、约瑟夫-路易·拉格朗日、卡尔·弗里德里希·高斯和迈克尔·法拉第研究了电与磁之间的关系,最终由詹姆斯·克拉克·麦克斯韦突然而戏剧性地统一为现在称为 电磁学(electromagnetism) 的综合理论。

在这一框架中,光是一种波状表现形式:灯泡灯丝中带电粒子(如电子)的运动会产生对周围 电场(electric field) 的扰动,这种扰动从光源向外传播。电场的振荡还会引起 磁场(magnetic field) 的次级振荡,而磁场的振荡又会强化电场的振荡,依此类推。这两个场的相互作用形成了一种自我传播的波,可以传播极远的距离:例如,夜空中可以看到的遥远恒星,它们的光可以传播数百万光年。在20世纪初,马克斯·普朗克、马克斯·玻恩、埃尔温·薛定谔和维尔纳·海森堡的研究进一步改变了我们的理解:在微观层面上,能量和动量等基本属性是量子化的,这意味着它们只能以某个基数的整数倍存在,这个基数被称为 量子(quantum) 。在电磁振荡的情况下,这个量子被称为 光子(photon) 。从这个意义上说,我们的物理理解走到了一个完整的循环:一旦转向非常小的尺度,光又表现出粒子般的行为,同时依然保持其整体的波动性。

我们的目标是通过模拟光线来生成逼真的图像,那么这个目标在整个过程中如何定位呢?面对这座不断增长的复杂解释之塔,一个根本性的问题出现了:为了实现照片级逼真度,我们需要攀登这座塔多高?幸运的是,答案是“并不需要攀得太高”。组成可见光的波非常小,其波长仅为几百纳米,从波峰到波谷。光的复杂波动行为出现在如此微小的尺度上,但当我们模拟尺度为厘米或米的物体时,这种行为几乎可以忽略不计。这是个好消息,因为在超过几微米的尺度上进行详细的波级模拟是不切实际的:如果要达到这种细节级别,计算机图形学就不可能以现在的形式存在。相反,我们主要使用在16世纪到19世纪初期发展起来的方程,这些方程将光线模型化为沿着射线传播的粒子。这种方法带来了一个更高效的计算方式,即基于一种称为 光线追踪(ray tracing) 的关键操作。

光线追踪在概念上是一个简单的算法;它基于跟踪光线在场景中的路径,随着光线与环境中的物体相互作用和反弹。尽管有许多方法可以编写光线追踪器,但所有这些系统至少模拟以下对象和现象:

- 相机(Cameras):相机模型决定了场景的观看方式和位置,包括如何在传感器上记录场景的图像。许多渲染系统从相机生成视线,然后追踪到场景中,以确定每个像素处可见的对象。

- 光线与物体的交点(Ray–object intersections):我们必须能够准确地确定给定光线与给定几何物体的交点。此外,我们需要确定交点处物体的某些属性,例如表面法线或其材质。大多数光线追踪器还具有测试光线与多个物体交点的功能,通常返回沿光线最近的交点。

- 光源(Light sources):没有照明,渲染场景就没有太大意义。光线追踪器必须模拟场景中光的分布,包括光源本身的位置以及它们如何在空间中分配能量。

- 可见性(Visibility):为了知道给定光源是否在表面上的某一点上沉积能量,我们必须知道从该点到光源是否存在不间断的路径。幸运的是,在光线追踪器中,这个问题很容易回答,因为我们可以从表面构建光线到光源,找到最近的光线-物体交点,并将交点距离与光源距离进行比较。

- 表面光散射(Light scattering at surfaces):每个物体必须提供其外观的描述,包括光如何与物体表面相互作用的信息,以及重新辐射(或 散射(scattered) )光的性质。表面散射模型通常被参数化,以便能够模拟多种外观。

- 间接光传输(Indirect light transport):因为光可以在反射或穿过其他表面后到达一个表面,通常需要追踪额外的光线以捕捉这一效果。

- 光线传播(Ray propagation):我们需要了解光沿着光线在空间中传播时发生了什么。如果我们在真空中渲染场景,光能量在光线沿途保持不变。尽管在地球上真正的真空是罕见的,但它们在许多环境中是一个合理的近似。对于通过雾、烟、地球大气等追踪光线,还有更复杂的模型可用。

我们将在本节中简要讨论这些模拟任务中的每一个。在下一节中,我们将展示 pbrt 与底层模拟组件的高级接口,并将介绍一种简单的渲染算法,该算法随机采样光线路径以生成图像。

1.2.1 摄像机和胶片(Cameras and Film)

几乎每个人都使用过相机,并且熟悉其基本功能:你表示希望记录下世界的图像(通常是通过按下按钮或轻触屏幕),图像就会被记录在一张胶片上或由电子传感器捕捉。最简单的拍照设备之一被称为 针孔相机(pinhole camera)。针孔相机由一个密闭的盒子和一端的小孔组成(图 1.2)。当孔被揭开时,光线进入并照射到固定在盒子另一端的摄影纸上。尽管其结构简单,这种相机至今仍被使用,主要用于艺术目的。为了在胶片上形成图像,需要较长的曝光时间以获得足够的光线。

图 1.2:针孔相机。 视景体由通过针孔投影的胶片决定。

尽管大多数相机比针孔相机复杂得多,但它是模拟的一个方便起点。相机最重要的功能是定义将记录到胶片上的场景部分。在图 1.2 中,我们可以看到将针孔连接到胶片边缘如何形成一个延伸到场景中的双锥体。位于这个锥体外的物体无法成像到胶片上。由于实际相机成像的形状比锥体更复杂,我们将可以潜在成像到胶片上的空间区域称为 视景体(viewing volume)。

另一种思考针孔相机的方法是将胶片平面放在针孔前面,但保持相同的距离(图 1.3)。请注意,将孔与胶片连接定义了与之前完全相同的视景体。当然,这并不是构建真实相机的实用方法,但对于模拟目的来说,这是一个方便的抽象。当胶片(或图像)平面位于针孔前面时,针孔通常被称为 眼睛(eye)。

图 1.3: 当我们模拟针孔相机时,我们将胶片放置在成像平面上的孔前,并将孔重新命名为 眼睛。

现在我们来到了渲染中的关键问题:在图像的每个点上,摄像机记录了什么颜色?这个问题的答案部分取决于在该点可见的场景部分。如果我们回想起原始的针孔相机,很明显,只有沿着针孔与胶片上某一点之间的向量传播的光线才能对该胶片位置产生贡献。在我们模拟的相机中,胶片平面位于眼睛前面,我们关注的是从图像点到眼睛的光线量。

因此,摄像机模拟器的一项重要任务是从图像中选取一个点,并生成 光线(rays),沿着这些光线入射的光将对该图像位置产生贡献。由于光线由一个起点和一个方向向量组成,因此对于图 1.3 中的针孔相机模型,这项任务特别简单:它使用针孔作为起点,从针孔到成像平面的向量作为光线的方向。对于涉及多个镜头的更复杂的相机模型,计算与图像中给定点对应的光线可能会更加复杂。

光沿着光线到达相机时,通常在不同波长下携带不同数量的能量。人类视觉系统将这种波长变化解释为颜色。大多数相机传感器记录与红色、绿色和蓝色对应的三种波长分布的单独测量,这足以重建场景对人类观察者的视觉外观。(第 4.6 节更详细地讨论了颜色。)因此,pbrt 中的相机还包括一种胶片抽象,既存储图像,又模拟胶片传感器对入射光的响应。

pbrt 的相机和胶片抽象在第 5 章中详细描述。图像位置转换为光线的过程被封装在相机模块中,而胶片抽象负责确定传感器对光的响应,渲染系统的其余部分可以专注于沿着这些光线评估光照。

1.2.2 光线与物体的交点(Ray–Object Intersections)

每次相机生成一条光线时,渲染器的第一个任务是确定该光线首先与哪个物体相交(如果有的话)以及相交发生的位置。这个交点是光线上的可见点,我们希望在这个点上模拟光与物体的相互作用。为了找到交点,我们必须测试光线与场景中所有物体的相交情况,并选择光线首先相交的那个物体。给定一条光线 \(\text{r}\) ,我们首先以 参数形式(parametric form) 表示它:

\[ \text{r}(\mathit{t}) = \text{o} + \mathit{t}\mathbf{d} \]

其中 \(\text{o}\) 是光线的起点,\(\mathbf{d}\) 是其方向向量,\(\mathit{t}\) 是一个参数,其合法范围是 \([0, \infty )\) 。我们可以通过指定其参数 \(\mathit{t}\) 值并评估上述方程来获得光线上的一个点。

通常很容易找到射线 \(\text{r}\) 和由隐式函数 \(F(x,y,z) = 0\) 定义的表面之间的交点。我们首先将射线方程代入隐式方程,产生一个新函数,其唯一参数是 \(\mathit{t}\) 。然后我们求解这个函数以得到 \(\mathit{t}\) ,并将最小的正根代入射线方程以找到所需的点。例如,中心在原点、半径为 \( r \) 的球体的隐式方程是

\[ x^2 + y^2 + z^2 - r^2 = 0 \]

替换光线方程,我们得到

\[ (\text{o}_x + t\mathbf{d}_x)^2 + (\text{o}_y + t\mathbf{d}_y)^2 + (\text{o}_z + t\mathbf{d}_z)^2 - r^2 = 0 \]

下标表示点或向量的相应分量。对于给定的光线和给定的球体,除了 \( t \) 以外的所有值都是已知的,这给我们提供了一个在 \( t \) 中容易求解的二次方程。如果没有实根,则光线与球体相交;如果有根,则最小的正根给出交点。

交点本身对于光线追踪器来说信息不足;它需要知道该点表面的某些属性。首先,必须确定该点材质的表示并传递给光线追踪算法的后续阶段。其次,还需要关于交点的额外几何信息,以便对该点进行着色。例如,表面法线 \( \mathbf{n} \) 始终是必需的。尽管许多光线追踪器仅使用 \( \mathbf{n} \) ,但更复杂的渲染系统如 pbrt 需要更多的信息,例如关于表面局部参数化的各种位置和表面法线的偏导数。

图 1.4: 莫阿娜岛(Moana Island) 场景,由 pbrt 渲染。该模型来自一部动画电影,展示了为电影渲染场景的极端复杂性(华特迪士尼动画工作室 2018)。它包含超过 1.46 亿个独特三角形,但由于广泛使用对象实例化,场景的真实几何复杂性实际上达到了数百亿个三角形。(场景由华特迪士尼动画工作室提供(Scene courtesy of Walt Disney Animation Studios)。)

当然,大多数场景由多个对象组成。暴力方法是依次测试每个对象的光线,选择所有交点中最小的正 \( t \) 值以找到最近的交点。这种方法虽然正确,但速度非常慢,即使对于复杂度适中的场景也是如此。更好的方法是结合 加速结构(acceleration structure) ,在光线交点过程中快速排除整组对象。这种快速剔除无关几何体的能力意味着光线追踪通常在 \( O(m \log n) \) 时间内运行,其中 \( m \) 是图像中的像素数量,\( n \) 是场景中的对象数量。†(构建加速结构本身的时间至少是 O(n)。)得益于加速结构的有效性,可以在合理的时间内渲染出如图 1.4 所示的高度复杂场景。

pbrt 的几何接口及其对各种形状的实现描述在第 6 章中,加速接口及其实现则在第 7 章中展示。

1.2.3 光分布(Light Distribution)

光线与物体交点阶段为我们提供了一个需要着色的点以及该点的局部几何信息。请记住,我们的最终目标是找到从这个点朝向相机离开的光线量。为此,我们需要知道 到达(arriving) 该点的光线量。这涉及到场景中光线的 几何分布(geometric distribution ) 和 辐射分布(radiometric distribution ) 。对于非常简单的光源(例如,点光源),光照的几何分布仅仅是知道光源的位置。然而,现实世界中并不存在点光源,因此基于物理的光照通常基于 面(area) 光源。这意味着光源与一个几何物体相关联,该物体从其表面发出光照。然而,在本节中,我们将使用点光源来说明光分布的组成部分;光测量和分布的更严格讨论将在第 4 章和第 12 章中进行。

我们经常想知道在交点 \( \text{p} \) 周围的微分区域上沉积的光功率(图 1.5)。我们将假设点光源具有某个功率 \( \Phi \) ,并且它在所有方向上均匀辐射光。这意味着围绕光源的单位球面上的功率每单位面积为 \( \Phi/(4\pi) \) 。(这些测量将在第 4.1 节中进行解释和形式化。)

图 1.5: 用于确定由点光源到达点 \( \text{p} \) 的单位面积功率的几何构造。点到光源的距离用 \( r \) 表示。

如果我们考虑两个这样的球体(图 1.6),显然在较大球体上的某一点的单位面积功率必须小于在较小球体上的某一点的功率,因为相同的总功率分布在更大的面积上。具体来说,半径为 \( r \) 的球体上某一点到达的单位面积功率与 \( 1/r^2 \) 成正比。

图 1.6: 由于点光源在所有方向上均匀辐射光,因此相同的总功率会沉积在以光源为中心的所有球体上。

此外,可以证明,如果微小的表面 \( \text{d}A \) 以角度 \( \theta \) 倾斜,远离从表面点到光源的向量,则沉积在 \( \text{d}A \) 上的功率量与 \( \cos\theta \) 成正比。将这一切结合起来,单位面积的微分功率 \( \text{d}E \)(微分辐照度(differential irradiance))是

\[ \text{d}E = \frac{\Phi \cos \theta}{4 \pi r^2} \]

读者如果对计算机图形学中的基本光照已经熟悉,将会注意到这个方程中编码的两个熟悉的定律:上述提到的倾斜表面的余弦衰减,以及光随距离平方的倒数(one-over-\(r\)-squared)衰减。

图 1.7: 具有数千个光源的场景。这个场景的光源数量过多,无法在每个计算反射光的点上考虑所有光源。然而,可以通过对光源进行随机采样来高效渲染。 (场景由 Beeple 提供(Scene courtesy of Beeple)。)

多个光源的场景容易处理,因为光照是 线性(linear) 的:每个光源的贡献可以单独计算并相加以获得整体贡献。光的线性特性意味着可以应用复杂的算法在场景中每个着色点仅从部分光源随机采样光照;这是第 12.6 节的主题。图 1.7 显示了以这种方式渲染的具有数千个光源的场景。

1.2.4 可见性(Visibility)

前一节中描述的光照分布忽略了一个非常重要的组成部分:阴影(shadows)。只有当从点到光源位置的路径没有障碍时,每个光源才会对被着色的点提供照明(图 1.8)。

图 1.8: 只有当光源在接收点的视线中没有被遮挡时,光源才会将能量沉积在表面上。左侧的光源照亮了点 \( \text{p} \) ,而右侧的光源则没有。

幸运的是,在光线追踪器中,很容易确定从被着色的点是否能看到光源。我们只需构造一条新的光线,其起点位于表面点,方向指向光源。这些特殊的光线称为 阴影光线(shadow rays) 。如果我们在环境中追踪这条光线,我们可以通过比较任何找到的交点的参数 \( t \) 值与光源位置沿光线的参数 \( t \) 值,检查光线的起点与光源之间是否存在交点。如果光源与表面之间没有阻挡物,则光的贡献将被包含在内。

1.2.5 表面光散射(Light Scattering at Surfaces)

我们现在能够计算出两个对点进行正确着色至关重要的信息:其位置和入射光照。现在我们需要确定入射光在表面上的 散射(scattered) 情况。具体来说,我们对沿着我们最初追踪以找到交点的光线散射回来的光能量感兴趣,因为那条光线通向相机(图 1.9)。

图 1.9: 表面散射的几何表示。沿着方向 \( \omega_i \) 到达的入射光在点 \( \text{p} \) 与表面相互作用,并沿着方向 \( \omega_o \) 向相机散射回去。散射到相机的光量由入射光能量与 BRDF 的乘积给出。

场景中的每个物体提供了一种 材质(material) ,这是一种对其表面每个点外观属性的描述。这个描述由 双向反射分布函数(bidirectional reflectance distribution function)(BRDF)给出。该函数告诉我们从入射方向 \( \omega_i \) 反射到出射方向 \( \omega_o \) 的能量有多少。我们将 BRDF 在 \( \text{p} \) 处表示为 \( f_r(\text{p},\omega_o,\omega_i) \) 。(根据约定,方向 \( \omega \) 是单位向量。)

图 1.10: 使用 BSSRDF 模拟的散射模型头部。准确建模次表面光传输,而不是假设光在进入的同一点退出,极大地提高了渲染图像的真实感。(模型由 Infinite Realities, Inc. 提供(Model courtesy of Infinite Realities, Inc))

将 BRDF 的概念推广到透射光(获得 BTDF)或从表面任一侧到达的光的普遍散射是很容易的。描述一般散射的函数称为 双向散射分布函数(bidirectional scattering distribution function)(BSDF)。 pbrt 支持多种 BSDF 模型;它们在第 9 章中进行了描述。更复杂的是 双向散射表面反射分布函数(bidirectional scattering surface reflectance distribution function)(BSSRDF),它模拟光在不同于入射点的表面上退出。这对于再现如牛奶、大理石或皮肤等半透明材料是必要的。BSSRDF 在图 1.10 中进行了描述,显示了基于人头模型的 pbrt 渲染的图像,其中皮肤的散射使用 BSSRDF 进行建模。

1.2.6 间接光传输(Indirect Light Transport)

特纳·惠特德(Turner Whitted)在 1980 年发表的关于光线追踪的原始论文强调了其 递归(recursive) 特性,这一特性使得在渲染图像中包含间接*镜面反射(specular reflection)和透射(transmission )*成为可能。例如,如果从相机发出的光线击中一个像镜子一样的光滑物体,我们可以在交点处关于表面法线反射光线,并递归调用光线追踪例程以找到到达镜子上该点的光线,将其贡献添加到原始相机光线中。相同的技术也可以用于追踪与透明物体相交的透射光线。许多早期的光线追踪示例展示了镜子和玻璃球(图 1.11),因为这些类型的效果很难通过其他渲染技术捕捉。

(a) 惠特光线追踪 (Whitted ray tracing)

(b) 随机渐进光子映射 (Stochastic progressive photon mapping)

图 1.11: 早期光线追踪场景原型。注意镜面和玻璃物体的使用,这突显了算法处理这些表面的能力。(a) 使用 Whitted 1980 年的原始光线追踪算法渲染,(b) 使用 随机渐进光子映射(stochastic progressive photon mapping) (SPPM) 渲染,这是一种现代先进的光传输算法,将在第 sec:photon-mapping 节中介绍。SPPM 能够准确模拟通过球体的光的聚焦。

一般来说,从物体上的一个点到达相机的光量是由物体发出的光(如果它本身是光源)和反射光的总和给出的。这个想法通过 光传输方程(light transport equation)(通常也称为 渲染方程(rendering equation) )形式化,该方程根据 辐射度(radiance) 来测量光,辐射度是一个将在第 4.1 节中定义的辐射单位。它表示从点 \( \text{p} \) 在方向 \( \omega_o \) 上发出的辐射度 \( L_o(\text{p},\omega_o) \) 等于该点在该方向上的发射辐射度 \( L_e(\text{p},\omega_o) \) ,加上来自围绕球体 \( \text{S}^2 \) 上点 \( \text{p} \) 所有方向的入射辐射度,再乘以 BSDF \( f(\text{p},\omega_o,\omega_i) \) 和一个余弦项:

(1.1) \[ L_o(\text{p},\omega_o) = L_e(\text{p},\omega_o) + \int_{\text{S}^2} f(\text{p},\omega_o,\omega_i) L_i(\text{p},\omega_i) |\cos\theta_i| \text{d}\omega_i \]

我们将在第 4.3.1 节和第 13.1.1 节中展示该方程的更完整推导。除了最简单的场景外,解析地求解这个积分是不可能的,因此我们必须做出简化假设或使用数值积分技术。

Whitted 的光线追踪算法通过忽略来自大多数方向的入射光,简化了这个积分,仅对光源方向以及完美反射和折射的方向进行评估 \( L_i(\text{p},\omega_i) \) 。换句话说,它将积分转化为对少数方向的求和。在 1.3.6 节中,我们将看到简单的随机采样方程(1.1)可以创建包含复杂照明和复杂表面散射效果的真实图像。在本书的其余部分,我们将展示如何使用更复杂的随机采样算法大大提高这种通用方法的效率。

1.2.7 光线传播(Ray Propagation)

图 1.12: 使用参与介质建模的爆炸。因为 pbrt 能够在参与介质的详细模型中模拟光的发射、散射和吸收,因此能够渲染出像这样的图像。(场景由 Jim Price 提供(Scene courtesy of Jim Price)。)

到目前为止的讨论都假设光线在真空中传播。例如,在描述点光源的光分布时,我们假设光的能量在以光源为中心的球面上均匀分布,而在传播过程中没有减弱。烟雾、雾气或灰尘等 参与介质(participating media) 的存在可能会使这一假设失效。这些效应在模拟中非常重要:可以使用参与介质描述一大类有趣的现象。图 1.12 显示了由 pbrt 渲染的爆炸。更不戏剧性的是,几乎所有户外场景都受到参与介质的显著影响。例如,地球的大气使得远处的物体看起来饱和度较低。

参与介质可以通过两种方式影响沿光线传播的光。首先,介质可以 熄灭(extinguish)(或 衰减(attenuate) )光,或者通过吸收光,或者通过将光散射到不同的方向。我们可以通过计算光线起点与交点之间的 透射率(transmittance) \( T_r \) 来捕捉这种效果。透射率告诉我们在交点散射的光有多少能够返回到光线起点。

参与介质也可以沿着光线增加光的强度。这可以发生在介质发出光(如火焰)或介质将来自其他方向的光散射回光线时。我们可以通过对 体积光传输方程(volume light transport equation) 进行数值计算来找到这个量,方法与我们通过计算光传输方程以找到从表面反射的光的数量相同。我们将把参与介质和体积渲染的描述留到第 11 章和第 14 章。

1.3 pbrt:系统概述(System Overview)

pbrt 是使用标准面向对象技术构建的:对于每一个基本类型,系统指定了实现该类型必须满足的接口。例如, pbrt 要求在场景中表示几何图形的具体形状类型,需要实现一组方法,比如返回形状边界框(bounding box)的方法,和测试与给定光线是否相交的方法。反过来,系统中的大部分功能可以完全基于这些接口来实现;例如,检查光源与被着色点之间是否存在遮挡物的代码,只需调用形状的相交方法,而不必考虑场景中存在的具体形状类型。

表 1.1:主要接口类型。 pbrt 的大部分是基于 14 种关键基础类型实现的,如下所示。可以轻松地将每种实现添加到系统中以扩展其功能。

基础类型 源文件 章节 Spectrum base/spectrum.h, util/spectrum.h, util/spectrum.cpp 4.5 Camera base/camera.h, cameras.h, cameras.cpp 5.1 Shape base/shape.h, shapes.h, shapes.cpp 6.1 Primitive cpu/primitive.h, cpu/primitive.cpp,cpu/accelerators.h, cpu/accelerators.cpp 7.1 Sampler base/sampler.h, samplers.h, samplers.cpp 8.3 Filter base/filter.h, filters.h, filters.cpp 8.8.1 BxDF base/bxdf.h, bxdfs.h, bxdfs.cpp 9.1.2 Material base/material.h, materials.h, materials.cpp 10.5 FloatTexture SpectrumTexture base/texture.h, textures.h, textures.cpp 10.3 Medium base/medium.h, media.h, media.cpp 11.4 Light base/light.h, lights.h, lights.cpp 12.1 LightSampler base/lightsampler.h, lightsamplers.h, lightsamplers.cpp 12.6 Integrator cpu/integrators.h, cpu/integrators.cpp 1.3.3

这些关键基础类型总共有 14 种,汇总在表 1.1 中。将这些类型中的一个新实现添加到系统中是简单直接的;该实现必须提供所需的方法,必须编译并链接到可执行文件中,并且场景对象创建例程(“routine”(例程)通常指的是一段可以被重复调用的代码)必须修改,以便在解析场景描述文件时根据需要创建对象的实例。C.4 节更详细地讨论了如何扩展系统功能。

在 C++中,传统做法是使用定义纯虚函数的抽象基类为这些类型指定接口,并让实现类从这些基类继承并实现所需的虚函数。然后,编译器会负责生成代码,根据基类类型的指针调用适当的方法。这种方法在 pbrt 的前三个版本中使用,但由于在本版本中增加对图形处理单元(GPU)渲染的支持,促使采用一种更具可移植性的 基于标签调度(tag-based dispatch) 的方法,其中每个特定类型的实现被分配一个唯一的整数,以确定其在运行时的类型。(有关此主题的更多信息,请参见第 1.5.7 节。)在 pbrt 中以这种方式实现的多态(polymorphic)类型都在 base/ 目录中的头文件中定义。

此版本的 pbrt 能够在支持 C++17 并提供光线相交测试 API 的 GPU 上运行。我们精心设计了系统,使得几乎所有的 pbrt 实现都可以在 CPU 和 GPU 上运行,正如第 2 章到第 12 章中所展示的。因此,在接下来的大部分内容中,我们将很少提及 CPU 与 GPU 的区别。

在 pbrt 中,CPU 和 GPU 渲染路径之间的主要区别在于它们的数据流、如何实现高效化并行以及各部分如何连接起来。本章后面描述的基本渲染算法以及第 13 章和第 14 章中描述的光传输算法仅在 CPU 上可用。GPU 渲染管线在第 15 章中讨论,尽管它也可以在 CPU 上运行(但效率不如针对 CPU 的光传输算法)。

虽然 pbrt 在当前实现中可以很好地渲染许多场景,但它经常被学生、研究人员和开发者扩展。本节中有许多来自这些努力的成果展示。图 1.13、1.14 和 1.15 都是由一门渲染课程的学生创作的,最终的课堂项目是通过新功能扩展 pbrt ,以渲染之前无法渲染的图像。这些图像是该课程中最优秀的作品之一。

图 1.13: Guillaume Poncin 和 Pramod Sharma 以多种方式扩展了 pbrt ,实现了多种复杂的渲染算法,以制作这幅斯坦福大学的 CS348b 渲染比赛中的获奖图像。树木采用 L系统(L-systems)进行程序建模,发光图像处理滤镜增强了树上灯光的真实感,雪采用元球(metaballs)进行程序建模,次表面散射算法通过考虑光在雪下传播一段距离后再离开的效果,使雪呈现出真实的外观。

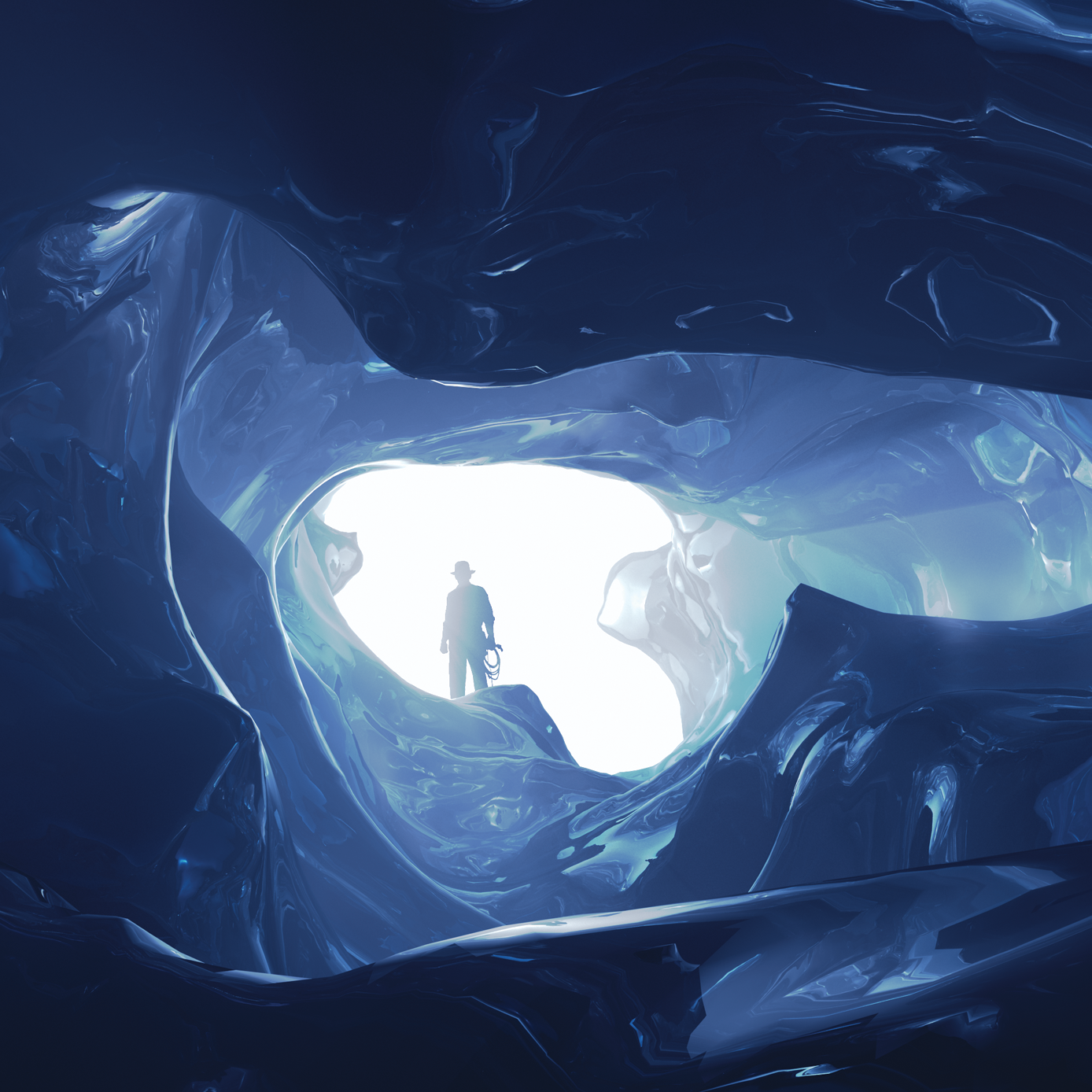

图 1.14: 阿贝·戴维斯、戴维·雅各布斯和郑敏·白渲染了这幅惊人的冰洞图像,赢得了 2009 年斯坦福大学 CS348b 渲染比赛的大奖。他们首先实现了冰川化(glaciation)的物理过程模拟,这一过程是指雪在多年间落下、融化并重新冻结,形成分层的冰层。然后,他们模拟了由于融水径流导致的冰的侵蚀,随后生成了冰的几何模型。体积内的光散射通过体积光子映射进行模拟;冰的蓝色完全是由于对冰体积中光的波长依赖吸收的建模。

图 1.15: 陈林孟、霍伯特·张和志仁·朱渲染了这张看起来美味的棉花糖在茶杯中的图像,以赢得 2018 年斯坦福 CS348b 渲染比赛的大奖。他们使用多层曲线建模棉花糖,然后在中心填充参与介质,以高效地模拟其内部的散射。

图 1.16: 马丁·卢比奇使用 Blender 模拟了这个奥地利皇室皇冠的场景;最初使用 LuxRender 渲染,该软件最初是 pbrt-v1 代码库的一个分支。皇冠由大约 350 万个三角形组成,受到六个区域光源的照明,这些光源的发射光谱基于来自真实光源的测量数据。最初在四核 CPU 上以每像素 1280 个样本的设置渲染,计算耗时 73 小时。在现代 GPU 上, pbrt 以相同的采样率可以在 184 秒内渲染此场景。

1.3.1 执行阶段(Phases of Execution)

pbrt 可以概念上分为三个执行阶段。在第一阶段,它解析用户提供的场景描述文件。场景描述是一个文本文件,指定构成场景的几何形状、它们的材质属性、照亮它们的光源、虚拟相机在场景中的位置,以及系统中使用的所有单个算法的参数。场景文件格式在 pbrt 网站 pbrt.org 上有详细文档。

解析阶段的结果是一个 BasicScene 类的实例,它存储场景规范,但尚未以适合渲染的形式存储。在执行的第二阶段, pbrt 创建与场景对应的特定对象;例如,如果指定了透视投影,则在此阶段会创建一个与指定视图参数对应的 PerspectiveCamera 对象。之前版本的 pbrt 将这两个阶段混合在一起,但在这个版本中我们将它们分开,因为 CPU 和 GPU 的渲染路径在内存中表示场景的某些方式不同。

在第三阶段,执行主渲染循环。这个阶段是 pbrt 通常花费大部分运行时间的地方,本书的大部分内容都专注于在这个阶段执行的代码。为了协调渲染, pbrt 实现了一个 积分器(integrator),之所以这样命名是因为它的主要任务是评估(evaluate)方程 (1.1) 中的积分。

1.3.2 pbrt 的 main函数(pbrt’s main() Function)

pbrt 可执行文件的 main() 函数在 pbrt 源码的 cmd/pbrt.cpp 中定义,位于 pbrt 分支的 src/pbrt 的目录中。它只有大约一百五十行代码,其中大部分用于处理命令行参数和相关的簿记。

/** 程序入口 */

int main(int argc, char *argv[]) {

/** 将命令行参数转换为字符串向量 */

std::vector<std::string> args = GetCommandLineArguments(argv);

/** 为要解析的命令行申明变量 */

PBRTOptions options;

std::vector<std::string> filenames;

/** 处理命令行参数 */

for (auto iter = args.begin(); iter != args.end(); ++iter) {

if ((*iter)[0] != '-') {

filenames.push_back(*iter);

continue;

}

auto onError = [](const std::string &err) {

usage(err);

exit(1);

};

std::string cropWindow, pixelBounds, pixel, pixelMaterial;

if (ParseArg(&iter, args.end(), "cropwindow", &cropWindow, onError)) {

std::vector<Float> c = SplitStringToFloats(cropWindow, ',');

if (c.size() != 4) {

usage("Didn't find four values after --cropwindow");

return 1;

}

options.cropWindow = Bounds2f(Point2f(c[0], c[2]), Point2f(c[1], c[3]));

} else if (ParseArg(&iter, args.end(), "pixel", &pixel, onError)) {

std::vector<int> p = SplitStringToInts(pixel, ',');

if (p.size() != 2) {

usage("Didn't find two values after --pixel");

return 1;

}

options.pixelBounds =

Bounds2i(Point2i(p[0], p[1]), Point2i(p[0] + 1, p[1] + 1));

} else if (ParseArg(&iter, args.end(), "pixelbounds", &pixelBounds, onError)) {

std::vector<int> p = SplitStringToInts(pixelBounds, ',');

if (p.size() != 4) {

usage("Didn't find four integer values after --pixelbounds");

return 1;

}

options.pixelBounds = Bounds2i(Point2i(p[0], p[2]), Point2i(p[1], p[3]));

} else if (ParseArg(&iter, args.end(), "pixelmaterial", &pixelMaterial, onError)) {

std::vector<int> p = SplitStringToInts(pixelMaterial, ',');

if (p.size() != 2) {

usage("Didn't find two values after --pixelmaterial");

return 1;

}

options.pixelMaterial = Point2i(p[0], p[1]);

} else if (

#ifdef PBRT_BUILD_GPU_RENDERER

ParseArg(&iter, args.end(), "gpu", &options.useGPU, onError) ||

ParseArg(&iter, args.end(), "gpu-device", &options.gpuDevice, onError) ||

#endif

ParseArg(&iter, args.end(), "debugstart", &options.debugStart, onError) ||

ParseArg(&iter, args.end(), "disable-pixel-jitter", &options.disablePixelJitter,

onError) ||

ParseArg(&iter, args.end(), "disable-texture-filtering",

&options.disableTextureFiltering, onError) ||

ParseArg(&iter, args.end(), "disable-wavelength-jitter", &options.disableWavelengthJitter,

onError) ||

ParseArg(&iter, args.end(), "displacement-edge-scale",

&options.displacementEdgeScale, onError) ||

ParseArg(&iter, args.end(), "display-server", &options.displayServer, onError) ||

ParseArg(&iter, args.end(), "force-diffuse", &options.forceDiffuse, onError) ||

ParseArg(&iter, args.end(), "format", &format, onError) ||

ParseArg(&iter, args.end(), "log-level", &logLevel, onError) ||

ParseArg(&iter, args.end(), "log-utilization", &options.logUtilization, onError) ||

ParseArg(&iter, args.end(), "log-file", &options.logFile, onError) ||

ParseArg(&iter, args.end(), "mse-reference-image", &options.mseReferenceImage, onError) ||

ParseArg(&iter, args.end(), "mse-reference-out", &options.mseReferenceOutput, onError) ||

ParseArg(&iter, args.end(), "nthreads", &options.nThreads, onError) ||

ParseArg(&iter, args.end(), "outfile", &options.imageFile, onError) ||

ParseArg(&iter, args.end(), "pixelstats", &options.recordPixelStatistics, onError) ||

ParseArg(&iter, args.end(), "quick", &options.quickRender, onError) ||

ParseArg(&iter, args.end(), "quiet", &options.quiet, onError) ||

ParseArg(&iter, args.end(), "render-coord-sys", &renderCoordSys, onError) ||

ParseArg(&iter, args.end(), "seed", &options.seed, onError) ||

ParseArg(&iter, args.end(), "spp", &options.pixelSamples, onError) ||

ParseArg(&iter, args.end(), "stats", &options.printStatistics, onError) ||

ParseArg(&iter, args.end(), "toply", &toPly, onError) ||

ParseArg(&iter, args.end(), "wavefront", &options.wavefront, onError) ||

ParseArg(&iter, args.end(), "write-partial-images", &options.writePartialImages,

onError) ||

ParseArg(&iter, args.end(), "upgrade", &options.upgrade, onError)) {

// success

} else if (*iter == "--help" || *iter == "-help" || *iter == "-h") {

usage();

return 0;

} else {

usage(StringPrintf("argument \"%s\" unknown", *iter));

return 1;

}

}

/** 初始化 pbrt */

InitPBRT(options);

/** 解析提供的场景描述文件 */

BasicScene scene;

BasicSceneBuilder builder(&scene);

ParseFiles(&builder, filenames);

/** 渲染场景 */

if (Options->useGPU || Options->wavefront)

RenderWavefront(scene);

else

RenderCPU(scene);

/** 渲染场景后的清理 */

CleanupPBRT();

}

相较于直接操作提供给 main() 函数的 argv 值, pbrt 将提供的参数转换为 std::string 的vector。这样做不仅是为了 string 类的更好的便利性,还支持非 ASCII 字符集。B.3.2 节提供了有关字符编码及其在 pbrt 中处理的更多信息。

/** 将命令行参数转换为字符串向量 */

std::vector<std::string> args = GetCommandLineArguments(argv);

我们将在书中仅包含一些 main 函数片段的定义。某些片段,例如处理用户提供的命令行参数的片段,既简单又长,不值得增加几页书的长度。然而,我们将包含声明存储选项值变量的片段。

/** 为要解析的命令行的申明变量 */

PBRTOptions options;

std::vector<std::string> filenames;

GetCommandLineArguments() 函数和 PBRTOptions 类型出现在页面边缘的 迷你索引(mini-index) 中,并附有它们定义所在页面的页码。迷你索引指向几乎所有在每页中使用或提及的函数、类、方法和成员变量的定义。(为了简洁起见,我们将从迷你索引中省略非常广泛使用的类,如 Ray ,以及在前几页刚刚介绍的类型或方法。)

PBRTOptions 类存储各种渲染选项,这些选项通常更适合在命令行中指定,而不是在场景描述文件中指定。例如, pbrt 在渲染过程中应该以何种详细程度报告其进度。它被传递给 InitPBRT() 函数,该函数汇总在进行其他工作之前必须执行的各种系统级初始化任务。例如,它初始化日志系统并启动一组用于 pbrt 并行化的线程。

/** 初始化 pbrt */

InitPBRT(options);

在参数被解析和验证后, ParseFiles() 函数接管处理前面描述的三个执行阶段中的第一个。借助于两个类 BasicSceneBuilder 和 BasicScene ,它们分别在 C.2 和 C.3 节中描述,它循环遍历提供的文件名,逐个解析每个文件。如果 pbrt 在没有提供文件名的情况下运行,它会从标准输入中查找场景描述。本书中不会描述场景描述文件的标记化和解析机制,但解析器的实现可以在 src/pbrt 目录中的 parser.h 和 parser.cpp 文件中找到。

/** 解析提供的场景描述文件 */

BasicScene scene;

BasicSceneBuilder builder(&scene);

ParseFiles(&builder, filenames);

在场景描述被解析后,将调用两个函数中的一个来渲染场景。 RenderWavefront() 同时支持 CPU 和 GPU 渲染路径,能够并行处理大约一百万个图像采样(image samples)。它是第 15 章的主题。 RenderCPU() 使用 Integrator 的实现来渲染场景,且仅支持在 CPU 上运行。它的并行性远低于 RenderWavefront() ,仅并行渲染与 CPU 线程数量相同的图像采样。

这两个函数首先都将 BasicScene 转换为适合高效渲染的形式,然后将控制权传递给特定处理器的积分器(processor-specific integrator)。(有关此过程的更多信息,请参见 C.3 节。)我们暂时略过这一转换的细节,以便专注于 RenderCPU() 中的主要渲染循环,这要有趣得多。为此,我们将高效的场景表示视为已获取。

/** 渲染场景 */

if (Options->useGPU || Options->wavefront)

RenderWavefront(scene);

else

RenderCPU(scene);

在图像渲染完成后, CleanupPBRT() 负责优雅地关闭系统,包括例如终止由 InitPBRT() 启动的线程。

/** 渲染场景后的清理 */

CleanupPBRT();

1.3.3 积分器接口(Integrator Interface)

在 RenderCPU() 渲染路径中,由实现 Integrator 接口的类的实例负责渲染。由于 Integrator 实现仅在 CPU 上运行,我们将定义 Integrator 作为具有纯虚方法的标准基类。 Integrator 类和各种实现分别定义在文件 cpu/integrators.h 和 cpu/integrators.cpp 中。

/** 积分器定义 */

class Integrator {

public:

/** 积分器公有方法 */

virtual ~Integrator();

static std::unique_ptr<Integrator> Create(const std::string &name,

const ParameterDictionary ¶meters,

Camera camera, Sampler sampler,

Primitive aggregate,

std::vector<Light> lights,

const RGBColorSpace *colorSpace,

const FileLoc *loc);

virtual std::string ToString() const = 0;

virtual void Render() = 0;

pstd::optional<ShapeIntersection> Intersect(const Ray &ray,

Float tMax = Infinity) const;

bool IntersectP(const Ray &ray, Float tMax = Infinity) const;

bool Unoccluded(const Interaction &p0, const Interaction &p1) const {

return !IntersectP(p0.SpawnRayTo(p1), 1 - ShadowEpsilon);

}

SampledSpectrum Tr(const Interaction &p0, const Interaction &p1,

const SampledWavelengths &lambda) const;

/** 积分器公有成员 */

Primitive aggregate;

std::vector<Light> lights;

std::vector<Light> infiniteLights;

protected:

/** 积分器保护方法 */

Integrator(Primitive aggregate, std::vector<Light> lights)

: aggregate(aggregate), lights(lights) {

// 积分器构造函数实现

Bounds3f sceneBounds = aggregate ? aggregate.Bounds() : Bounds3f();

for (auto &light : lights) {

light.Preprocess(sceneBounds);

if (light.Type() == LightType::Infinite)

infiniteLights.push_back(light);

}

}

};

Integrator 基类构造函数接受一个呈现场景中的所有几何对象的Primitive,以及一个包含场景中的所有光源的数组。

/** 积分器保护方法 */

Integrator(Primitive aggregate, std::vector<Light> lights)

: aggregate(aggregate), lights(lights) {

// 积分器构造函数实现

Bounds3f sceneBounds = aggregate ? aggregate.Bounds() : Bounds3f();

for (auto &light : lights) {

light.Preprocess(sceneBounds);

if (light.Type() == LightType::Infinite)

infiniteLights.push_back(light);

}

}

场景中的每个几何对象都由一个 Primitive 表示,该对象主要负责结合指定其几何形状的 Shape ,和描述其外观的 Material(例如,对象的颜色,或它的表面是哑光还是光泽的)。反过来,场景中的所有几何图元都被收集到一个存储在 Integrator::aggregate 成员变量中的单一聚合图元(single aggregate primitive)中。这个聚合是一个特殊类型的图元,它本身持有对许多其他图元的引用。聚合实现将场景中的所有图元存储在一个加速数据结构中,从而减少与距离给定光线较远的图元进行不必要的光线相交测试的次数。由于它实现了 Primitive 接口,因此对系统的其余部分来说,它与单个图元没有区别。

/** 积分器公共成员 */

Primitive aggregate;

std::vector<Light> lights;

场景中的每个光源由实现 Light 接口的对象表示,该接口允许光源指定其形状和发射的能量分布。有些光源需要知道整个场景的边界框,而在它们首次创建时这些信息是不可用的。因此, Integrator 构造函数调用它们的 Preprocess() 方法,提供这些边界。此时任何“无限”的光源也会存储在一个单独的数组中。这种光源将在第 12.5 节中介绍,为无限远的光源建模,例如,这是一个用于模拟地球表面接收到的天光(skylight)的合理的模型。有时仅循环遍历这些无限光源是有必要的,对于有成千上万光源的场景,循环遍历所有光源以找到这些无限光源是低效的。

// 积分器构造函数实现

Bounds3f sceneBounds = aggregate ? aggregate.Bounds() : Bounds3f();

for (auto &light : lights) {

light.Preprocess(sceneBounds);

if (light.Type() == LightType::Infinite)

infiniteLights.push_back(light);

}

/** 积分器公有成员 */

std::vector<Light> infiniteLights;

Integrators 必须提供 Render() 方法的实现,该方法不接受其他参数。该方法在场景表示初始化完成后由 RenderCPU() 函数调用。积分器的任务是根据聚合图元和光源渲染场景。除此之外,具体的积分器使用其所需的其他类(例如,相机模型)来定义它要渲染的场景。此接口有意设计得非常通用,以允许广泛的实现——例如,可以实现一个 Integrator ,它仅在分布在场景中的稀疏点集上测量光,而不是生成常规的 2D 图像。

/** 积分器公有方法 */

virtual void Render() = 0;

Integrator 类提供了两个与光线-图元相交相关的方法供其子类使用。 Intersect() 接受一条光线和一个最大参数距离 tMax ,在场景中追踪给定的光线,如果在 tMax 之前沿光线有交点的话,返回一个被光线击中最近的图元对应的 ShapeIntersection 对象。( ShapeIntersection 结构在第 6.1.3 节中定义。)需要注意的是,此方法使用类型 pstd::optional 作为返回值,而不是来自 C++ 标准库的 std::optional ;我们在 pstd 命名空间中重新实现了标准库的部分内容,原因在第 1.5.5 节中讨论。

/** 积分器方法定义 */

pstd::optional<ShapeIntersection>

Integrator::Intersect(const Ray &ray, Float tMax) const {

if (aggregate) return aggregate.Intersect(ray, tMax);

else return {};

}

请注意 Intersect() 函数签名中首字母大写的浮点类型 Float :几乎 pbrt 中所有的浮点值都被声明为 Float 。 (唯一的例外是少数情况下需要特定的 32 位 float 或 64 位 double (例如,当将二进制值保存到文件时)。) 根据 pbrt 的编译标志, Float 是 float 或 double 的别名,尽管在实践中单精度 float 几乎总是足够的。 Float 的定义在 pbrt.h 头文件中,该文件被 pbrt 中的所有其他源文件包含。

/** Float 浮点类型定义 */

#ifdef PBRT_FLOAT_AS_DOUBLE

using Float = double;

#else

using Float = float;

#endif

Integrator::IntersectP() 与 Intersect() 方法密切相关。它检查沿着光线是否存在交点,但仅返回一个布尔值,指示是否找到交点。(其名称中的“P”表示它是一个评估谓词(evaluates a predicate)的函数(在编程中,谓词(predicate)通常指的是一个返回布尔值(true或false)的函数。),使用了 Lisp 编程语言中的常见命名约定。)由于它不需要搜索最近的交点或返回关于交点的额外几何信息, IntersectP() 通常比 Integrator::Intersect() 更高效。此例程用于阴影光线。

/** 积分器方法定义 */

bool Integrator::IntersectP(const Ray &ray, Float tMax) const {

if (aggregate) return aggregate.IntersectP(ray, tMax);

else return false;

}

1.3.4 图像块积分器和主渲染循环(ImageTileIntegrator and the Main Rendering Loop)

在实现一个基本的积分器以模拟光传输来渲染图像之前,我们将定义两个 Integrator 子类,这些子类提供该积分器以及许多后续积分器实现所需的额外通用功能。我们从 ImageTileIntegrator 开始,它继承自 Integrator 。下一节定义 RayIntegrator ,它继承自 ImageTileIntegrator 。

pbrt 的所有基于 CPU 的积分器都使用相机模型来定义视图参数并渲染图像,并通过将图像分割成块(tile)并让不同的处理器处理不同的块来实现渲染的并行化。因此, pbrt 包含一个 ImageTileIntegrator ,为这些任务提供通用功能。

/** 图像块积分器定义 */

class ImageTileIntegrator : public Integrator {

public:

/** 图像块积分器公有方法 */

ImageTileIntegrator(Camera camera, Sampler sampler,

Primitive aggregate, std::vector<Light> lights)

: Integrator(aggregate, lights), camera(camera),

samplerPrototype(sampler) {}

void Render();

virtual void EvaluatePixelSample(Point2i pPixel, int sampleIndex,

Sampler sampler, ScratchBuffer &scratchBuffer) = 0;

protected:

/** 图像块积分器保护成员 */

Camera camera;

Sampler samplerPrototype;

};

除了聚合和光源, ImageTileIntegrator 构造函数接受一个 Camera,该参数指定视图和镜头参数,如位置、方向、焦距和视场。由相机存储的 Film 处理图像存储。 Camera 类是第 5 章的大部分内容, Film 在第 5.4 节中描述。 Film 负责将最终图像写入文件。

构造函数还接受一个 Sampler ;它的作用更为微妙,但其实现可以显著影响系统生成的图像质量。首先,采样器负责选择图像平面上的点,以确定最初追踪到场景中的光线。其次,它负责提供随机样本值,这些值被积分器用于估计光传输积分的值,方程(1.1)。例如,一些积分器需要选择光源上的随机点,以计算来自区域光源的照明。生成这些样本的良好分布是渲染过程中的一个重要部分,可以显著影响整体效率;这个主题是第 8 章的主要焦点。

/** 图像块积分器公有方法 */

ImageTileIntegrator(Camera camera, Sampler sampler,

Primitive aggregate, std::vector<Light> lights)

: Integrator(aggregate, lights), camera(camera),

samplerPrototype(sampler) {}

/** 图像块积分器保护成员 */

Camera camera;

Sampler samplerPrototype;

对于 pbrt 的所有积分器,每个像素计算的最终颜色基于随机采样算法。如果每个像素的最终值是多个样本的平均值,则图像质量会提高。在样本数量较少时,采样误差(sampling error)表现为图像中的颗粒状高频噪声(grainy high-frequency noise),随着样本数量的增加,误差以可预测的速率下降。(此主题在第 2.1.4 节中有更深入的讨论。)因此, ImageTileIntegrator::Render() 将图像分成若干 波次(waves) 进行渲染,每个像素每次只处理少量样本。在前两波中,每个像素只取一个样本。在下一波中,每个像素取两个样本,每波的样本数量逐渐翻倍,直到达到一个限制。虽然最终图像的效果与图像是按波次渲染还是在一个像素中取完所有样本再转到下一个像素没有区别,但这种计算方式使得在渲染过程中可以看到最终图像的预览,其中所有像素都有一些样本,而不是只有少数像素有许多样本,其余像素没有样本。

因为 pbrt 是并行化以使用多个线程运行的,因此这种方法需要找到一个平衡。线程在获取新图像块的工作时会产生一定的开销,而一些线程在每波次结束时可能会变得空闲,因为它们没有更多的工作可做,而其他线程仍在处理它们被分配的图像块。这些考虑促使了限制翻倍方法的使用。

/** 图像块积分器方法定义 */

void ImageTileIntegrator::Render() {

/** 声明用于分块渲染图像的公共变量 */

ThreadLocal<ScratchBuffer> scratchBuffers(

[]() { return ScratchBuffer(); } );

ThreadLocal<Sampler> samplers(

[this]() { return samplerPrototype.Clone(); });

Bounds2i pixelBounds = camera.GetFilm().PixelBounds();

int spp = samplerPrototype.SamplesPerPixel();

ProgressReporter progress(int64_t(spp) * pixelBounds.Area(), "Rendering",

Options->quiet);

int waveStart = 0, waveEnd = 1, nextWaveSize = 1;

/** 按波次渲染图像 */

while (waveStart < spp) {

/** 并行渲染当前波次的图像块 */

ParallelFor2D(pixelBounds, [&](Bounds2i tileBounds) {

/** 渲染 tileBounds 提供的图像块 */

ScratchBuffer &scratchBuffer = scratchBuffers.Get();

Sampler &sampler = samplers.Get();

for (Point2i pPixel : tileBounds) {

/** 渲染像素 pPixel 中的样本 */

for (int sampleIndex = waveStart; sampleIndex < waveEnd; ++sampleIndex) {

sampler.StartPixelSample(pPixel, sampleIndex);

EvaluatePixelSample(pPixel, sampleIndex, sampler, scratchBuffer);

scratchBuffer.Reset();

}

}

progress.Update((waveEnd - waveStart) * tileBounds.Area());

});

/** 更新开始和结束波次 */

waveStart = waveEnd;

waveEnd = std::min(spp, waveEnd + nextWaveSize);

nextWaveSize = std::min(2 * nextWaveSize, 64);

/** 可选的将当前图像写入磁盘 */

if (waveStart == spp || Options->writePartialImages || referenceImage) {

ImageMetadata metadata;

metadata.renderTimeSeconds = progress.ElapsedSeconds();

metadata.samplesPerPixel = waveStart;

if (waveStart == spp || Options->writePartialImages) {

camera.InitMetadata(&metadata);

camera.GetFilm().WriteImage(metadata, 1.0f / waveStart);

}

}

}

}

在渲染开始之前,需要一些额外的变量。首先,积分器的实现需要分配少量临时内存,以存储在计算每条光线的贡献过程中表面散射属性。大量的内存分配可能会轻易地压倒系统的常规内存分配例程(例如, new ),这些例程必须协调多线程维护复杂的数据结构以跟踪空闲内存。一个简单的实现可能会在内存分配器中花费相当大一部分的计算时间。

为了解决这个问题, pbrt 提供了一个 ScratchBuffer 类,该类管理一块小的预分配内存缓冲区。 ScratchBuffer 分配非常高效,只需增加偏移量。 ScratchBuffer 不允许独立释放分配;相反,所有分配必须一次性释放,但这样做只需重置该偏移量。

因为 ScratchBuffer 在多个线程同时使用时不安全,所以为每个线程使用 ThreadLocal 模板类创建一个单独的实例。它的构造函数接受一个返回其管理的对象类型的新实例的 lambda 函数:在这里,调用默认的 ScratchBuffer 构造函数就足够了。 ThreadLocal 然后处理了为每个线程维护对象的独立副本的细节,并按需分配这些副本。

/** 声明用于分块渲染图像的公共变量 */

ThreadLocal<ScratchBuffer> scratchBuffers(

[]() { return ScratchBuffer(); } );

大多数 Sampler 实现发现维护一些状态是有用的,例如当前像素的坐标。这意味着多个线程不能同时使用单个 Sampler ,因此 ThreadLocal 也用于 Sampler 管理。 Samplers 提供了一个 Clone() 方法,用于创建其采样器类型的新实例。在开始时提供给 ImageTileIntegrator 构造函数的采样器 samplerPrototype ,在这里提供这些副本。

/** 声明用于分块渲染图像的公共变量 */

ThreadLocal<Sampler> samplers(

[this]() { return samplerPrototype.Clone(); });

提供给用户渲染工作完成多少以及还需要多长时间的指示是很有帮助的。这个任务由 ProgressReporter 类处理,它的第一个参数是工作项的总数。在这里,工作总量是每个像素采样的数量乘以总像素数。使用 64 位精度来计算这个值是很重要的,因为 32 位 int 可能不足以处理具有多个每像素样本的高分辨率图像。

/** 声明用于分块渲染图像的公共变量 */

Bounds2i pixelBounds = camera.GetFilm().PixelBounds();

int spp = samplerPrototype.SamplesPerPixel();

ProgressReporter progress(int64_t(spp) * pixelBounds.Area(), "Rendering",

Options->quiet);

接下来,当前波次中要采集的样本范围由 waveStart 和 waveEnd 给出; nextWaveSize 给出下一波中要采集的样本数量。

/** 声明用于分块渲染图像的公共变量 */

int waveStart = 0, waveEnd = 1, nextWaveSize = 1;

手握这些变量,渲染继续进行,直到在所有像素中采集到所需数量的样本。

/** 按波次渲染图像 */

while (waveStart < spp) {

/** 并行渲染当前波次的图像块 */

ParallelFor2D(pixelBounds, [&](Bounds2i tileBounds) {

/** 渲染 tileBounds 提供的图像块 */

ScratchBuffer &scratchBuffer = scratchBuffers.Get();

Sampler &sampler = samplers.Get();

for (Point2i pPixel : tileBounds) {

/** 渲染像素 pPixel 中的样本 */

for (int sampleIndex = waveStart; sampleIndex < waveEnd; ++sampleIndex) {

sampler.StartPixelSample(pPixel, sampleIndex);

EvaluatePixelSample(pPixel, sampleIndex, sampler, scratchBuffer);

scratchBuffer.Reset();

}

}

progress.Update((waveEnd - waveStart) * tileBounds.Area());

});

/** 更新开始和结束波次 */

waveStart = waveEnd;

waveEnd = std::min(spp, waveEnd + nextWaveSize);

nextWaveSize = std::min(2 * nextWaveSize, 64);

/** 可选的将当前图像写入磁盘 */

if (waveStart == spp || Options->writePartialImages || referenceImage) {

ImageMetadata metadata;

metadata.renderTimeSeconds = progress.ElapsedSeconds();

metadata.samplesPerPixel = waveStart;

if (waveStart == spp || Options->writePartialImages) {

camera.InitMetadata(&metadata);

camera.GetFilm().WriteImage(metadata, 1.0f / waveStart);

}

}

}

ParallelFor2D() 函数遍历图像块,多个循环迭代并发运行;它是第 B.6 节中介绍的与并行相关的实用函数的一部分。C++ lambda 表达式提供了循环体。 ParallelFor2D() 自动选择图像块的大小,以平衡两个方面:一方面,我们希望图像块的数量显著多于系统中的处理器数量。某些块的处理时间可能会少于其他块,因此如果处理器与块之间存在 1:1 的映射,那么一些处理器在完成工作后将处于空闲状态,而其他处理器则继续处理其图像区域。(图 1.17 显示了渲染示例图像块所需时间的分布,说明了这一问题。)另一方面,块过多也会影响效率。线程在并行 for 循环中获取更多工作时,会有一个小的固定开销,块越多,这个开销付出的代价就越大。因此, ParallelFor2D() 选择的块大小考虑了待处理区域的范围和系统中的处理器数量。

/** 并行渲染当前波次的图像块 */

ParallelFor2D(pixelBounds, [&](Bounds2i tileBounds) {

/** 渲染 tileBounds 提供的图像块 */

ScratchBuffer &scratchBuffer = scratchBuffers.Get();

Sampler &sampler = samplers.Get();

for (Point2i pPixel : tileBounds) {

/** 渲染像素 pPixel 中的样本 */

for (int sampleIndex = waveStart; sampleIndex < waveEnd; ++sampleIndex) {

sampler.StartPixelSample(pPixel, sampleIndex);

EvaluatePixelSample(pPixel, sampleIndex, sampler, scratchBuffer);

scratchBuffer.Reset();

}

}

progress.Update((waveEnd - waveStart) * tileBounds.Area());

});

图 1.17:图 1.11 中场景每个瓦片渲染所花费时间的直方图。 横轴以秒为单位测量时间。注意执行时间的广泛变化,说明图像的不同部分需要的计算量有显著差异。

给定一个要渲染的瓦片,实现在开始时会为当前执行的线程获取 ScratchBuffer 和 Sampler 。如前所述, ThreadLocal::Get() 方法负责为每个线程分配和返回它们的独立实例的细节。

有了这些,实现使用基于范围的 for 循环遍历图像块中的所有像素,该循环使用 Bounds2 类提供的迭代器,然后通知 ProgressReporter 已完成的工作量。

/** 渲染 tileBounds 提供的图像块 */

ScratchBuffer &scratchBuffer = scratchBuffers.Get();

Sampler &sampler = samplers.Get();

for (Point2i pPixel : tileBounds) {

/** 渲染像素 pPixel 中的样本 */

for (int sampleIndex = waveStart; sampleIndex < waveEnd; ++sampleIndex) {

sampler.StartPixelSample(pPixel, sampleIndex);

EvaluatePixelSample(pPixel, sampleIndex, sampler, scratchBuffer);

scratchBuffer.Reset();

}

}

progress.Update((waveEnd - waveStart) * tileBounds.Area());

给定一个像素以进行一个或多个采样,通过 StartPixelSample() 通知线程的 Sampler 应该开始为当前像素生成样本,这使采样器能够根据当前正在处理的像素来设置任何内部状态。积分器的 EvaluatePixelSample() 方法负责确定具体样本的值,之后调用 ScratchBuffer::Reset() 来释放它在 [ScratchBuffer] 中分配的临时内存。

/** 渲染像素 pPixel 中的样本 */

for (int sampleIndex = waveStart; sampleIndex < waveEnd; ++sampleIndex) {

sampler.StartPixelSample(pPixel, sampleIndex);

EvaluatePixelSample(pPixel, sampleIndex, sampler, scratchBuffer);

scratchBuffer.Reset();

}

提供了纯虚方法 Integrator::Render() 的实现后, ImageTileIntegrator 现在要求其子类实现接下来的 EvaluatePixelSample() 方法。

/** 图像块积分器公有方法 */

virtual void EvaluatePixelSample(Point2i pPixel, int sampleIndex,

Sampler sampler, ScratchBuffer &scratchBuffer) = 0;

在当前波次的并行 for 循环完成后,计算下一波要处理的样本索引范围。

/** 更新开始和结束波次 */

waveStart = waveEnd;

waveEnd = std::min(spp, waveEnd + nextWaveSize);

nextWaveSize = std::min(2 * nextWaveSize, 64);

如果用户提供了 –write-partial-images 命令行选项,则在处理下一波样本之前,正在进行的图像会写入磁盘。我们在这里不包括处理此操作的片段,可选的将当前图像写入磁盘。

1.3.5 光线积分器实现(RayIntegrator Implementation)

正如 ImageTileIntegrator 集中处理与将图像分解为瓦片的积分器相关的功能, RayIntegrator 为从相机开始追踪光线路径的积分器提供通用功能。在第 13 章和第 14 章中实现的所有积分器都继承自 RayIntegrator 。

/** 光线积分器定义 */

class RayIntegrator : public ImageTileIntegrator {

public:

/** 光线积分器公有方法 */

RayIntegrator(Camera camera, Sampler sampler, Primitive aggregate,

std::vector<Light> lights)

: ImageTileIntegrator(camera, sampler, aggregate, lights) {}

void EvaluatePixelSample(Point2i pPixel, int sampleIndex,

Sampler sampler, ScratchBuffer &scratchBuffer) final;

virtual SampledSpectrum Li(

RayDifferential ray, SampledWavelengths &lambda, Sampler sampler,

ScratchBuffer &scratchBuffer, VisibleSurface *visibleSurface) const = 0;

};

它的构造函数只是将提供的对象传递给 ImageTileIntegrator 构造函数。

/** 光线积分器公有方法 */

RayIntegrator(Camera camera, Sampler sampler, Primitive aggregate,

std::vector<Light> lights)

: ImageTileIntegrator(camera, sampler, aggregate, lights) {}

RayIntegrator 实现了来自 ImageTileIntegrator 的纯虚方法 EvaluatePixelSample() 。在给定的像素处,它使用其 Camera 和 Sampler 生成一条射线进入场景,然后调用由子类提供的 Li() 方法,以确定沿该射线到达图像平面的光量。正如我们将在后面的章节中看到的,该方法返回的值的单位与射线起点的入射光谱辐射有关,通常在方程中用符号 \( L_\text{i} \) 表示——该方法的名称也因此而来。该值被传递给 Film ,记录射线对图像的贡献。

图 1.18 总结了该方法中使用的主要类及他们之间的数据流。

图 1.18: RayIntegrator::EvaluatePixelSample() 中执行计算的类之间的关系。 Sampler 为每个要采样的图像提供样本值。 Camera 将样本转换为来自胶片平面(film plane)的相应光线, Li() 方法计算到达胶片的该光线上的辐射亮度(radiance)。样本及其辐射亮度被传递给 Film ,后者将它们的贡献存储在图像中。

/** 光线积分器方法定义 */

void RayIntegrator::EvaluatePixelSample(Point2i pPixel, int sampleIndex,

Sampler sampler, ScratchBuffer &scratchBuffer) {

/** 采样光线的波长 */

Float lu = sampler.Get1D();

SampledWavelengths lambda = camera.GetFilm().SampleWavelengths(lu);

/** 为当前样本初始化CameraSample */

Filter filter = camera.GetFilm().GetFilter();

CameraSample cameraSample = GetCameraSample(sampler, pPixel, filter);

/** 为当前样本生成摄像机光线 */

pstd::optional<CameraRayDifferential> cameraRay =

camera.GenerateRayDifferential(cameraSample, lambda);

/** 追踪有效的摄像机光线(cameraRay) */

SampledSpectrum L(0.);

VisibleSurface visibleSurface;

if (cameraRay) {

/** 根据图像采样率缩放摄像机光线微分 */

Float rayDiffScale =

std::max<Float>(.125f, 1 / std::sqrt((Float)sampler.SamplesPerPixel()));

cameraRay->ray.ScaleDifferentials(rayDiffScale);

/** 沿摄像机光线评估辐射亮度 */

bool initializeVisibleSurface = camera.GetFilm().UsesVisibleSurface();

L = cameraRay->weight *

Li(cameraRay->ray, lambda, sampler, scratchBuffer,

initializeVisibleSurface ? &visibleSurface : nullptr);

/** 如果返回意外的辐射亮度值,则发出警告 */

if (L.HasNaNs()) {

LOG_ERROR("Not-a-number radiance value returned for pixel (%d, "

"%d), sample %d. Setting to black.",

pPixel.x, pPixel.y, sampleIndex);

L = SampledSpectrum(0.f);

} else if (IsInf(L.y(lambda))) {

LOG_ERROR("Infinite radiance value returned for pixel (%d, %d), "

"sample %d. Setting to black.",

pPixel.x, pPixel.y, sampleIndex);

L = SampledSpectrum(0.f);

}

}

/** 将摄像机光线的贡献值添加到图像中 */

camera.GetFilm().AddSample(pPixel, L, lambda, &visibleSurface,

cameraSample.filterWeight);

}

每个光线在多个离散波长 \( \lambda \) (默认四个)上携带辐射。当计算每个像素的颜色时, pbrt 在不同的像素样本中选择不同的波长,以便最终结果更好地反映所有波长的正确结果。为了选择这些波长,首先由 Sampler 提供一个样本值 lu 。该值在范围 \( [0,1) \) 内均匀分布。然后, Film::SampleWavelengths() 方法将此样本映射到一组特定波长,把它的胶片传感器响应模型当作一个关于波长的函数。大多数 Sampler 实现确保如果在一个像素中采样多个样本,这些样本在总体上均匀分布在 \( [0,1] \) 上。相应的,它们确保采样的波长在有效波长范围内也均匀分布,从而提高图像质量。

/** 采样光线的波长 */

Float lu = sampler.Get1D();

SampledWavelengths lambda = camera.GetFilm().SampleWavelengths(lu);

CameraSample 结构记录了相机应生成光线的胶片位置。该位置受到采样器提供的样本位置和用于将给像素的多个样本值过滤为单个值的重建滤波器(reconstruction filter)的影响。 GetCameraSample() 处理这些计算。 CameraSample 还存储与光线相关的时间以及镜头位置样本,这些在渲染移动物体的场景和模拟非针孔光圈的相机模型时使用。

/** 为当前样本初始化CameraSample */

Filter filter = camera.GetFilm().GetFilter();

CameraSample cameraSample = GetCameraSample(sampler, pPixel, filter);

Camera 接口提供了两种生成光线的方法: GenerateRay() 返回给定图像采样位置的光线,以及 GenerateRayDifferential() 返回 光线微分(ray differential) ,包含相机在图像平面的 \( x \) 和 \( y \) 方向上与样本相距一个像素的位置生成的光线的信息。光线微分用于从第 10 章中定义的一些纹理函数中获得更好的结果,通过使得能够计算纹理随像素间距变化的速度,这是一种纹理抗锯齿的关键组成部分。

某些 CameraSample 值可能与给定相机的有效光线不一致。因此,用 pstd::optional 来包装相机返回的 CameraRayDifferential 。

/** 为当前样本生成摄像机光线 */

pstd::optional<CameraRayDifferential> cameraRay =

camera.GenerateRayDifferential(cameraSample, lambda);

如果摄像机光线有效,它将在一些额外准备后传递给 RayIntegrator 子类的 Li() 方法实现。除了返回沿光线 \( \text{L} \) 的辐射亮度外,子类还负责初始化 VisibleSurface 类的一个实例,该实例记录光线在每个像素处与表面相交(如果有的话)的几何信息,以供 Film 实现使用,例如 GBufferFilm ,它在每个像素处存储的不仅仅是颜色的信息。

/** 追踪有效的摄像机光线(cameraRay) */

SampledSpectrum L(0.);

VisibleSurface visibleSurface;

if (cameraRay) {

/** 根据图像采样率缩放摄像机光线微分 */

/** 沿摄像机光线评估辐射亮度 */

/** 如果返回意外的辐射亮度值,则发出警告 */

}

在将光线传递给 Li() 方法之前, ScaleDifferentials() 在每个像素进行多个采样时,会调整微分光线的比例,以考虑到胶片平面上样本之间的实际间距。。

/** 根据图像采样率缩放摄像机光线微分 */

Float rayDiffScale =

std::max<Float>(.125f, 1 / std::sqrt((Float)sampler.SamplesPerPixel()));

cameraRay->ray.ScaleDifferentials(rayDiffScale);

对于不在每个像素处存储几何信息的 Film 实现,节省填充 VisibleSurface 类的工作是值得的。因此,只有在必要时,才会在调用 Li() 方法时传递指向该类的指针,否则传递空指针。积分器实现应仅在 VisibleSurface 非空时进行初始化。

CameraRayDifferential 还携带与光线相关的权重,用于缩放返回的辐射值。对于简单的相机模型,每条光线的权重相等,但更准确模拟透镜系统成像过程的相机模型可能会生成一些贡献大于其他光线的光线。这种相机模型可能会模拟在胶片平面的边缘到达的光线少于中心的效果,这种效果称为 渐晕(vignetting) 。

/** 沿摄像机光线评估辐射亮度 */

bool initializeVisibleSurface = camera.GetFilm().UsesVisibleSurface();

L = cameraRay->weight *

Li(cameraRay->ray, lambda, sampler, scratchBuffer,

initializeVisibleSurface ? &visibleSurface : nullptr);

RayIntegrator 子类必须实现纯虚方法 Li() 。它返回在指定波长采样时,给定光线的起点处的入射辐射,。

/** 光线积分器公有方法 */

virtual SampledSpectrum Li(

RayDifferential ray, SampledWavelengths &lambda, Sampler sampler,

ScratchBuffer &scratchBuffer, VisibleSurface *visibleSurface) const = 0;

渲染过程中的出现的 bugs 的一个常见副作用是计算出不可能的辐射值。例如,除以零会导致辐射值等于 IEEE 浮点无穷大或“不是一个数字(not a number)”值。渲染器会查找这些可能性,并在遇到时打印错误消息。这里我们不包括执行此操作的片段,/** 如果返回意外的辐射亮度值,则发出警告 */。如果您对其细节感兴趣,请参见 cpu/integrators.cpp 中的实现。

在已知光线起始处的辐射亮度后,调用 Film::AddSample() 更新图像中相应的像素,给定样本的加权辐射亮度。样本值如何记录在胶片中的细节在第 5.4 节和第 8.8 节中解释。

/** 将摄像机光线的贡献值添加到图像中 */

camera.GetFilm().AddSample(pPixel, L, lambda, &visibleSurface,

cameraSample.filterWeight);

1.3.6 随机游走积分器(Random Walk Integrator)

尽管我们花了几页时间整理积分器基础设施的实现终于完成了 RayIntegrator ,但现在我们可以在一个比实现完整的 Integrator::Render() 方法更简单的上下文中转向实现光传输积分算法。本节中我们将描述的 RandomWalkIntegrator 继承自 RayIntegrator ,因此多线程的所有细节、从相机生成初始光线以及沿着该光线将辐射度添加到图像的过程都已处理好。积分器在一个更简单的上下文中操作:给定一条光线,其任务是计算到达其起点的辐射度。

请回忆在第 1.2.7 节中我们提到,在没有参与介质的情况下,光线通过自由空间时所携带的光是不变的。在实现这个积分器时,我们将忽略参与介质的可能性,这使我们能够迈出第一步:给定光线与场景中几何体的第一次交点,到达光线起点的辐射度等于从交点朝向光线起点发出的辐射度。该出射辐射(outgoing radiance)由光传输方程(1.1)给出,尽管以封闭形式评估它是不可能的。需要采用数值方法,而在 pbrt 中使用的方法基于蒙特卡罗积分(Monte Carlo integration),这使得可以通过对被积函数进行逐点计算来估计积分的值。第 2 章提供了蒙特卡罗积分的介绍,额外的蒙特卡罗技术将在书中使用到时进行介绍。

为了计算出射辐射, RandomWalkIntegrator 实现了一种基于增量构建 随机游走(random walk) 的简单蒙特卡洛方法,其在场景表面上连续随机选择一系列点,以构建从相机开始的光携带路径。这种方法有效地反向模拟了现实世界中的图像形成,从相机而不是从光源发出光线。在这方面向后推导在物理上仍然是有效的,因为 pbrt 所基于的光的物理模型是时间可逆的。

图 1.19:使用 RandomWalkIntegrator 渲染的 水彩(Watercolor) 场景的图像。 由于 RandomWalkIntegrator 无法完美处理镜面表面,桌子上的两个玻璃杯呈黑色。此外,即使使用每像素 8,192 个样本来渲染此图像,结果仍然布满高频噪声。(例如,请注意远处的墙壁和椅子的底部。) (场景由 Angelo Ferretti 提供。)(Scene courtesy of Angelo Ferretti)

尽管随机游走采样算法的实现总共只有二十多行代码,但它能够模拟复杂的光照和着色效果;图 1.19 显示了使用该算法渲染的图像。(不过,该图像的计算耗费了许多小时才能达到这样的质量。)在本节的其余部分,我们将略过一些积分器实现的数学细节,专注于对该方法的直观理解,后续章节将填补这些空白,并更严格地解释这一点以及更复杂的技术。

/** 随机游走积分器定义 */

class RandomWalkIntegrator : public RayIntegrator {

public:

/** 随机游走积分器 公有方法 */

RandomWalkIntegrator(int maxDepth, Camera camera, Sampler sampler,

Primitive aggregate, std::vector<Light> lights)

: RayIntegrator(camera, sampler, aggregate, lights), maxDepth(maxDepth) {}

static std::unique_ptr<RandomWalkIntegrator> Create(

const ParameterDictionary ¶meters, Camera camera, Sampler sampler,

Primitive aggregate, std::vector<Light> lights, const FileLoc *loc);

std::string ToString() const;

SampledSpectrum Li(RayDifferential ray, SampledWavelengths &lambda,

Sampler sampler, ScratchBuffer &scratchBuffer,

VisibleSurface *visibleSurface) const {

return LiRandomWalk(ray, lambda, sampler, scratchBuffer, 0);

}

private:

/** 随机游走积分器 私有方法 */

SampledSpectrum LiRandomWalk(RayDifferential ray,

SampledWavelengths &lambda, Sampler sampler,

ScratchBuffer &scratchBuffer, int depth) const {

/** 让光线与场景相交并在没有交点时返回 */

pstd::optional<ShapeIntersection> si = Intersect(ray);

if (!si) {

/** 返回从无限远光源发出的光 */

SampledSpectrum Le(0.f);

for (Light light : infiniteLights)

Le += light.Le(ray, lambda);

return Le;

}

SurfaceInteraction &isect = si->intr;

/** 获取表面交点的发射辐射 */

Vector3f wo = -ray.d;

SampledSpectrum Le = isect.Le(wo, lambda);

/** 如果达到最大递归深度则终止随机游走 */

if (depth == maxDepth)

return Le;

/** 在随机游走交点计算 BSDF */

BSDF bsdf = isect.GetBSDF(ray, lambda, camera, scratchBuffer, sampler);

/** 为随机游走随机采样离开表面时的方向 */

Point2f u = sampler.Get2D();

Vector3f wp = SampleUniformSphere(u);

/** 在采样方向评估表面的 BSDF */

SampledSpectrum fcos = bsdf.f(wo, wp) * AbsDot(wp, isect.shading.n);

if (!fcos)

return Le;

/** 递归追踪光线以估计表面的入射辐射亮度 */

ray = isect.SpawnRay(wp);

return Le + fcos * LiRandomWalk(ray, lambda, sampler, scratchBuffer,

depth + 1) / (1 / (4 * Pi));

}

/** 随机游走积分器 私有成员 */

int maxDepth;

};

这个积分器递归地评估随机游走。因此,它的 Li() 方法实现几乎只是通过调用 LiRandomWalk() 方法来启动递归。大多数传递给 Li() 的参数只是被传递下去,因此这个简单的积分器忽略 VisibleSurface ,取而代之添加一个额外的参数来跟踪递归的深度。

/** 随机游走积分器 公有方法 */

SampledSpectrum Li(RayDifferential ray, SampledWavelengths &lambda,

Sampler sampler, ScratchBuffer &scratchBuffer,

VisibleSurface *visibleSurface) const {

return LiRandomWalk(ray, lambda, sampler, scratchBuffer, 0);

}

/** 随机游走积分器 私有方法 */

SampledSpectrum LiRandomWalk(RayDifferential ray,

SampledWavelengths &lambda, Sampler sampler,

ScratchBuffer &scratchBuffer, int depth) const {

/** 让光线与场景相交并在没有交点时返回 */

/** 获取表面交点的发射辐射 */

/** 如果达到最大递归深度则终止随机游走 */

/** 在随机游走交点计算 BSDF */

/** 为随机游走随机采样离开表面时的方向 */

/** 在采样方向评估表面的 BSDF */

/** 递归追踪光线以估计表面的入射辐射亮度 */

}

第一步是找到光线与场景中形状的最近交点。如果没有找到交点,那么光线就已经离开场景。否则,作为 ShapeIntersection 结构一部分返回的 SurfaceInteraction 提供了关于交点局部几何属性的信息。

/** 让光线与场景相交并在没有交点时返回 */

pstd::optional<ShapeIntersection> si = Intersect(ray);

if (!si) {

/** 返回从无限远光源发出的光 */

SampledSpectrum Le(0.f);

for (Light light : infiniteLights)

Le += light.Le(ray, lambda);

return Le;

}

SurfaceInteraction &isect = si->intr;

如果没有找到交点,辐射仍然可能沿着光线传播,因为存在一些没有几何形状的光源,例如 ImageInfiniteLight 。 Light::Le() 方法允许这些光源为给定光线返回其辐射。

/** 返回从无限远光源发出的光 */

SampledSpectrum Le(0.f);

for (Light light : infiniteLights)

Le += light.Le(ray, lambda);

return Le;

如果找到了有效的交点,我们必须在交点处评估光传输方程。第一个项,\( L_\text{e}(\text{p},\omega_\text{o}) \) ,即发射辐射,比较简单:发射是场景规格的一部分,发射辐射可以通过调用 SurfaceInteraction::Le() 方法获得,该方法接受关注的出射方向。在这里,我们关注的是沿光线方向发射回来的辐射。如果物体不是发射体,该方法将返回一个零值的光谱分布(zero-valued spectral distribution)。

/** 获取表面交点的发射辐射 */

Vector3f wo = -ray.d;

SampledSpectrum Le = isect.Le(wo, lambda);

评估光传输方程的第二项需要计算在交点 \( \text{p} \) 周围的方向球面上的积分。可以应用蒙特卡罗积分原理来表明,如果以相等的概率选择所有可能的方向 \( \omega' \) ,则积分的估值可以计算为 BSDF \( f \) (材质在 \( \text{p} \) 处的的光散射特性)、入射光照 \( L_\text{i} \) 以及一个余弦因子的加权乘积:

\[ \int_{\text{S}^2}^{} f(\text{p},\omega_\text{o},\omega_\text{i}) L_\text{i}(\text{p},\omega_\text{i}) |\cos{\theta_\text{i}}| \text{d}\omega_\text{i} \approx \frac{f(\text{p},\omega_\text{o},\omega') L_\text{i}(\text{p},\omega') |\cos{\theta'}|}{1/4\pi} \]

换句话说,给定一个随机方向 \( \omega' \) ,估计积分的值需要评估该方向下被积函数中的项,然后乘以一个因子 \( 4\pi \) 进行缩放。(这个因子在 A.5.2 节中推导,与单位球的表面积有关。)由于只考虑一个方向,因此与积分的真实值相比,蒙特卡洛估计几乎总是存在误差。然而,可以证明像这样的估计 在期望上(in expectation) 是正确的:非正式地说,它们在平均上给出了正确的结果。对多个独立估计取平均通常会减少这种误差——因此,采取每个像素多个样本的做法。

BSDF 和估计的余弦因子很容易评估,那么只剩下一个未知的 \( L_\text{i} \) ,即入射辐射。然而,请注意,我们发现自己又回到了最初调用 LiRandomWalk() 的地方:我们有一条光线,我们希望找到起点的入射辐射——这将通过对 LiRandomWalk() 的递归调用来提供。

在计算积分的估计值之前,我们必须考虑递归的终止条件。 RandomWalkIntegrator 在预定的最大深度 maxDepth 处停止。如果没有这个终止条件,算法可能永远不会终止(例如,想象一个镜子迷宫的场景)。这个成员变量在构造函数中根据可以在场景描述文件中设置的参数进行初始化。

/** 随机游走积分器 私有成员 */

int maxDepth;

/** 如果达到最大递归深度则终止随机游走 */

if (depth == maxDepth)

return Le;

如果随机游走没有终止,则调用 SurfaceInteraction::GetBSDF() 方法找到交点处的 BSDF。它评估纹理函数以确定表面属性,然后初始化 BSDF 的表示。通常需要为构成 BSDF 表示的对象分配内存;因为这段内存只需要在处理当前光线时激活,所以提供 ScratchBuffer 供其进行分配。

/** 在随机游走交点计算 BSDF */

BSDF bsdf = isect.GetBSDF(ray, lambda, camera, scratchBuffer, sampler);

接下来,我们需要随机采样一个方向 \( \omega' \) 来计算方程(1.2)中的估值。 SampleUniformSphere() 函数返回单位球面上的均匀分布方向,输入由采样器提供的两个均匀值 \( [0, 1) \) 。

/** 为随机游走随机采样离开表面时的方向 */

Point2f u = sampler.Get2D();

Vector3f wp = SampleUniformSphere(u);

除了入射辐射外,蒙特卡洛估计的所有因素现在都可以轻松评估。 BSDF 类提供了一个 f() 方法,该方法评估一对指定方向的 BSDF,并且可以使用 AbsDot() 函数计算与表面法线夹角的余弦,该函数返回两个向量之间点积的绝对值。如果向量是归一化的(在这里都是),则该值等于它们之间夹角余弦的绝对值(第 3.3.2 节)。

BSDF 在提供的方向上可能为零值,因此 fcos 也可能为零——例如,当表面不透光而两个方向位于其相对两侧时,BSDF 为零。在这种情况下,没有理由继续随机游走,因为后续点对结果没有贡献。

/** 在采样方向评估表面的 BSDF */

SampledSpectrum fcos = bsdf.f(wo, wp) * AbsDot(wp, isect.shading.n);

if (!fcos)

return Le;

剩余的任务是计算在采样方向 \( \omega' \) 上离开表面的新光线。这个任务由 SpawnRay() 方法处理,该方法返回在提供方向上离开交点的光线,确保光线与表面有足够的偏移,以避免因舍入误差而错误地重新相交。给定光线后,可以递归调用 LiRandomWalk() 来估计入射辐射,从而完成方程 (1.2) 的估计。

/** 递归追踪光线以估计表面的入射辐射亮度 */

ray = isect.SpawnRay(wp);

return Le + fcos * LiRandomWalk(ray, lambda, sampler, scratchBuffer,

depth + 1) / (1 / (4 * Pi));

这种简单的方法有许多缺点。例如,如果发射表面很小,大多数光线路径将找不到任何光照,但是需要追踪许多光线以形成准确的图像。在点光源的极限情况下,图像将是黑色,因为与这样的光源相交的概率为零。类似的问题也适用于在集中方向上散射光的 BSDF 模型。在完美镜子的极限情况下,它沿单一方向散射入射光, RandomWalkIntegrator 将永远无法随机采样该方向。

这些问题以及更多问题可以通过更复杂的蒙特卡罗积分技术来解决。在后续章节中,我们将介绍一系列改进,以获得更准确的结果。第 13 到 15 章中定义的积分器是这些发展的巅峰。所有这些仍然基于 RandomWalkIntegrator 中使用的基本思想,但比它更高效和稳健。图 1.20 将 RandomWalkIntegrator 与其中一个改进的积分器进行比较,并展示了可能的改进程度。

(a) RandomWalkIntegrator 随机游走积分器

(b) PathIntegrator 路径积分器

图 1.20:使用每像素 32 个样本渲染的 水彩(Watercolor) 场景。 (a) 使用 RandomWalkIntegrator 渲染。(b) 使用 PathIntegrator 渲染,采用相同的一般方法,但使用更复杂的蒙特卡洛技术。 PathIntegrator 在大致相同的工作量下提供了显著更好的图像,均方误差减少了 \( 54.5\times \) 。

1.4 如何阅读本书(How to Proceed through This Book)

我们编写本书时假设读者会大致按照从前到后的顺序阅读。我们尽量减少对尚未介绍的概念和接口的前向引用,但我们假设读者在文章的任何特定点上都熟悉之前的内容。有些章节深入探讨了一些高级主题,某些读者可能希望在第一次阅读时跳过;每个高级章节在标题中用星号标识。

由于系统的模块化特性,主要要求读者需要熟悉如 Point3f 、 Ray 和 SampledSpectrum 的底层类、表 1.1 中列出的抽象基类定义的接口、以及最终调用积分器的 RayIntegrator::Li() 方法的渲染循环。有了这些知识,假如读者如果不关心基于透视投影矩阵的相机模型如何将 CameraSample 映射到光线,可以跳过该相机的实现,只需记住 Camera::GenerateRayDifferential() 方法以某种方式将 CameraSample 转换为 RayDifferential 。

本书的其余部分分为四个主要部分,每个部分包含几章。首先,第 2 章到第 4 章介绍了系统的基础。第 2 章简要介绍了蒙特卡罗积分的关键思想,第 3 章描述了广泛使用的几何类,如 Point3f 、 Ray 和 Bounds3f 。第 4 章介绍了用于测量光的物理单位以及 pbrt 用于表示光谱分布的 SampledSpectrum 类。它还讨论了颜色和人类对光谱的感知,这影响了输入如何提供给渲染器以及它如何生成输出。

本书的第二部分涵盖了图像形成以及场景几何的表示。第 5 章定义了 Camera 接口和几种不同的相机实现,然后讨论将到达胶片的光谱辐射转化为图像的整体过程。第 6 章介绍了 Shape 接口,并给出了多个形状的实现,包括如何与它们进行光线相交测试。第 7 章描述了加速结构的实现,这些结构通过跳过与光线可以明确不相交的图元的测试,使光线追踪更高效。最后,第 8 章的主题是 Sampler 类,这些类在图像平面上放置样本,并为蒙特卡洛积分提供随机样本。

书的第三部分讲述了光以及光如何在表面和参与介质中散射。第 9 章包括一系列定义不同类型表面反射的类。第 10 章中描述的材质使用这些反射函数来实现多种不同的表面类型,如塑料、玻璃和金属。材料属性(颜色、粗糙度等)的空间变化通过纹理建模,这些纹理在第 10 章中也有描述。第 11 章介绍了描述光在参与介质中如何散射和吸收的抽象,而第 12 章则描述了光源的接口和各种光源实现。

最后一部分将书中其余部分的所有想法汇集在一起,以实现一些有趣的光传输算法。第 13 章和第 14 章中的积分器代表了蒙特卡罗积分在计算光传输方程的更准确近似值方面的多种不同应用,相较于 随机游走积分器 。第 15 章随后描述了在 GPU 上运行的高性能积分器的实现,该实现基于与 CPU 积分器实现中使用的相同类的实现。

第 16 章,书的最后一章,提供了对系统设计决策的简要回顾和讨论,以及一些比练习中更具深远意义的项目建议。附录包含更多的蒙特卡罗采样算法,描述工具函数,并解释在解析输入文件时场景描述的创建细节。

1.4.1 练习(The Exercises)

在每一章的末尾,您会找到与该章所涵盖的内容相关的练习。每个练习被标记为三种难度级别之一:

① 一个应该只需一到两个小时便能完成的练习

② 适合当作课后作业的阅读和实现任务,预计需要 10 到 20 小时来完成

③ 可能需要 40 小时或更长时间才能完成的课程的最终项目

1.4.2 查看图像(Viewing the Images)

本书中的图表比较了使用不同算法渲染同一场景的结果。与本书的前几版一样,我们尽力确保这些差异在印刷页上显而易见,尽管即使是高质量的印刷也无法与现代显示技术相匹配,尤其是在高动态范围显示器广泛可用的情况下。

因此,我们已将本章中使用的所有渲染图像在线提供。例如,本章中作为图 1.1 显示的第一张图像可以在网址 pbr-book.org/4ed/fig/1.1 找到。其他所有图像均遵循相同的命名规则。

1.4.3 在线版(The Online Edition)

从 2023 年 11 月 1 日起,本书的全部内容将在 pbr-book.org/4ed 上免费在线提供。(本书的前一版已在该网站上提供。)

在线版包含了由于页面限制无法包含在印刷书籍中的额外内容。所有这些材料都是本书内容的补充。例如,它包括一个额外相机模型的实现、一个 kd-tree 加速结构,以及关于双向光传输算法的完整章节。(几乎所有额外材料都在本书的前一版中出现过。)

1.5 使用和理解代码(Using and Understanding the Code)

pbrt 源代码分发可从 pbrt.org 获取。该网站还包括额外的文档、使用 pbrt 渲染的图像、示例场景、勘误表以及错误报告系统的链接。我们鼓励您访问该网站并订阅 pbrt 邮件列表。

pbrt 是用 C++编写的,但我们努力限制使用语言的复杂特性来使其对非 C++专家更易理解。紧密围绕核心语言特性也有助于系统的可移植性。我们会在适用时利用 C++的扩展标准库,但在文本中不会讨论对标准库函数调用的语义。我们期望读者在必要时查阅标准库的文档。

我们将偶尔在书中省略 pbrt 的源代码的短部分。例如,当有多个几乎相同的代码需要处理时,我们将展示一个案例,并说明其余案例的代码已从文本中省略。默认的类构造函数通常不显示,文本中也不包括每个源文件开头的各种 #include 指令等细节。所有省略的代码可以在 pbrt 源代码分发中找到。

1.5.1 源代码组织(Source Code Organization)

用于构建 pbrt 的源代码位于 pbrt 发行版中的 src 目录下。在该目录中有 src/ext ,其中包含 pbrt 使用的各种第三方库的源代码,以及 src/pbrt ,其中包含 pbrt 的源代码。我们在书中不会讨论第三方库的实现。

src/pbrt 目录中的源文件主要由各种接口类型的实现组成。例如, shapes.h 和 shapes.cpp 实现了 Shape 接口, materials.h 和 materials.cpp 实现了材质,等等。该目录还包含解析 pbrt 的场景描述文件的源代码。

src/pbrt 中的 pbrt.h 头文件是系统中所有其他源文件包含的第一个文件。它包含了一些宏和广泛使用的前向声明,因此我们尽量保持其简短,并最小化它包含的其他头文件数量,以提高编译时间效率。

src/pbrt 目录还包含多个子目录。它们具有以下作用:

- base : 头文件定义了表 1.1 中列出的 12 种常见类型的接口( Primitive 和 Integrator 仅限 CPU 运行,因此在 cpu 目录中的文件中定义)。

- cmd : 包含为 pbrt 构建的可执行文件的 main() 函数的源文件。 (除了 pbrt 可执行文件之外,还包括 imgtool ,它执行各种图像处理操作,以及 pbrt_test ,它包含单元测试。)

- cpu : CPU 特定代码,包括 Integrator 的实现。

- gpu : GPU 特定代码,包括在 GPU 上分配内存和启动工作的函数。

- util : 底层工具程序代码,其中大部分与渲染无关。

- wavefront : WavefrontPathIntegrator的实现 ,该内容在第 15 章中介绍。该积分器可在 CPU 和 GPU 上运行。

1.5.2 命名约定(Naming Conventions)

函数和类通常使用驼峰命名法命名,每个单词的首字母大写且没有空格分隔。一个例外是某些容器类的方法,当它们具有相应的功能时,遵循 C++标准库的命名约定(例如, size() 和 begin() 和 end() 用于迭代器)。变量也使用驼峰命名法,但首字母小写,除了少数全局变量。

我们还尝试在命名中匹配数学符号:例如,我们使用变量 p 表示点 \( \text{p} \) ,使用 w 表示方向 \( \omega \) 。我们有时会在变量的末尾添加一个 p 来表示带撇号的符号: wp 表示 \( \omega' \) 。下划线用于表示方程中的下标:例如 theta_o 表示 \( \theta_\text{o} \) 。

然而,我们对下划线的使用并不完全一致。短变量名通常省略下划线——我们使用 wi 表示 \( \omega_\text{i} \) ,并且我们已经看到 Li 用于 \( L_\text{i} \) 。我们有时也使用下划线将一个单词与小写数学符号分开。例如,我们使用 Sample_f 表示一个对函数 \( f \) 进行采样的方法,而不是 Samplef ,这样会更难阅读,或者 SampleF ,这会模糊与函数 \( f \) 的联系(“函数 \( F \) 是在哪里定义的?”)。

1.5.3 指针还是引用?(Pointer or Reference?)

C++ 提供了两种不同的机制来将对象引用传递给函数或方法:指针和引用。如果函数参数不打算作为输出变量,可以使用任一方式来节省在栈上传递整个结构的开销。在 pbrt 中的约定是,当参数会被函数或方法完全改变时使用指针,当其内部状态会被改变但不会完全重新初始化时使用引用,而当参数根本不会被改变时使用 const 引用。这个规则的一个重要例外是,当我们希望能够传递 nullptr 来指示参数不可用或不应使用时,我们将始终使用指针。

1.5.4 抽象与效率(Abstraction versus Efficiency)

在设计软件系统的接口时,主要的关注点之一是合理权衡抽象与效率。例如,许多程序员严格地将所有类中的所有数据设为 private ,并提供方法来获取或修改数据项的值。对于简单类(例如, Vector3f ),我们认为这种方法无谓地隐藏了实现的一个基本属性——该类持有三个浮点坐标——我们可以合理地期望它们永远不会改变。当然,不使用隐藏信息并暴露所有类内部的细节会导致代码维护的噩梦,但我们认为在系统中明智地暴露基本设计决策没有任何问题。例如, Ray 用一个点、一个向量、一个时间和它所处的介质来表示的事实是一个不需要隐藏在抽象层背后的决策。当这些细节被暴露时,其他地方的代码更简洁且更易于理解。

在编写软件系统并进行这些权衡时,重要的一点是要考虑系统的预期最终规模。 pbrt 大约有 70,000 行代码,永远不会增长到一百万行代码;这一事实应体现在系统中使用的信息隐藏量上。设计接口以适应一个复杂度更高的系统将浪费程序员的时间(并可能导致运行时效率低下)。

1.5.5 pstd

我们在 pstd 命名空间中重新实现了 C++ 标准库的一个子集;这是为了能够在 CPU 和 GPU 上可互换地使用这些部分。为了阅读 pbrt 的源代码, pstd 中的任何内容都提供与 std 中相应实体相同的功能、类型和方法。因此,我们在此文本中将不记录 pstd 的使用。

1.5.6 分配器(Allocators)

几乎所有在 pbrt 中表示场景的对象的动态内存分配都是使用提供给对象创建方法的 Allocator 实例进行的。在 pbrt 中, Allocator 是 C++标准库的 pmr::polymorphic_allocator 类型的简写。它的定义在 pbrt.h 中,以便所有其他源文件都可以使用。

/** 定义 Allocator */

using Allocator = pstd::pmr::polymorphic_allocator<std::byte>;

std::pmr::polymorphic_allocator 实现提供了一些分配和释放对象的方法。下列三种方法在 pbrt 中被广泛使用:†(由于 pmr::polymorphic_allocator 是最近才添加到 C++ 中且未被广泛使用,于是我们破例再此列出标准库功能)

void *allocate_bytes(size_t nbytes, size_t alignment);

template <class T> T *allocate_object(size_t n = 1);

template <class T, class... Args> T *new_object(Args &&... args);

第一个, allocate_bytes() 分配指定字节数量的内存。接下来, allocate_object() 分配一个指定类型 T 的包含 n 个对象的数组,使用其默认构造函数初始化每个对象。最后一个方法, new_object() ,分配一个类型为 T 的单个对象,并使用提供的参数调用其构造函数。每种分配类型都有相应的释放方法: deallocate_bytes() , deallocate_object() 和 delete_object() 。

与 C++ 标准库中的数据结构使用分配器相关的一个棘手细节是,一旦容器的构造函数运行完毕,其分配器是固定的。因此,如果一个容器被赋值给另一个容器,目标容器的分配器不会改变,即使它存储的所有值都已更新。(即使在 C++ 的移动语义下也是如此。)因此,常见的情况是,在 pbrt 中的对象构造函数在成员初始化列表中传递分配器给它们存储的容器,即使它们尚未准备好设置存储在其中的值。

使用显式内存分配器而不是直接调用 new 和 delete 有几个优点。它不仅使跟踪已分配内存的总量变得简单,而且还使替换为许多小分配优化的分配器变得容易,这在第 7 章构建加速结构时非常有用。以这种方式使用分配器还使在使用 GPU 渲染时将场景对象存储在 GPU 可见的内存中变得简单。

1.5.7 动态调度(Dynamic Dispatch)

如第 1.3 节所述,虚函数通常不用于 pbrt 中的多态类型的动态调度(主要例外是 Integrator )。相反, TaggedPointer 类用于表示指向指定类型集合之一的指针;它包括运行时类型识别及随之而来的动态调度的机制。(其实现可以在附录 B.4.4 中找到。)使用它的原因有两个。

首先,在 C++中,继承自抽象基类的对象实例包含一个隐藏的虚函数表指针,用于解析虚函数调用。在大多数现代系统中,这个指针使用八个字节的内存。虽然八个字节看起来不算多,但我们发现,在使用之前版本的 pbrt 渲染复杂场景时,仅用于形状和图元的虚函数指针就会消耗大量内存。使用 TaggedPointer 类时,类型信息没有增量存储成本。

虚函数表的另一个问题是它们存储指向可执行代码的函数指针。当然,这正是它们应该做的,但这一特性意味着虚函数表可以有效地用于来自 CPU 或 GPU 的方法调用,但不能同时用于两者,因为不同处理器的可执行代码存储在不同的内存位置。当使用 GPU 进行渲染时,能够从两个处理器调用方法是很有用的。

对于所有仅调用多态对象方法的代码,使用 pbrt 的 TaggedPointer 代替虚函数没有任何区别,除了方法调用是使用 . 运算符进行的,就像用 C++ 引用一样。第 4.5.1 节介绍了 Spectrum ,这是书中出现的第一个基于 TaggedPointer 的类,关于 pbrt 的动态调度方案的实现有更多细节。

1.5.8 代码优化(Code Optimization)

我们试图通过使用精心选择的算法而不是局部微优化来使 pbrt 高效,以便系统更容易理解。然而,效率是渲染的一个不可或缺的部分,因此我们在整本书中都会讨论性能问题。

对于 CPU 和 GPU 而言,处理器性能的增长速度持续快于从主内存加载数据到处理器的速度。这意味着等待从内存中获取值可能成为一个主要的性能瓶颈。我们讨论的最重要的优化与最小化不必要的内存访问以及以有助于一致访问模式的方式组织算法和数据结构有关;关注这些问题可以比减少执行的总指令数更大程度地加快程序执行速度。

1.5.9 调试和日志记录(Debugging and Logging)

调试渲染器可能很具挑战性,特别是在结果大多数时候是正确的但并非总是正确的情况下。 pbrt 包含了许多便利工具来简化调试。

最重要的之一是一套单元测试。我们发现单元测试在 pbrt 的开发中是不可或缺的,因为它提供了被测试功能很可能是正确的保证。有了这种保证,可以减轻调试时诸如“我能确定这里使用的哈希表不是我错误的来源吗?”这样的问题背后的担忧。或者,失败的单元测试几乎总是比渲染器生成的不正确图像更容易调试;许多测试是在调试 pbrt 的过程中添加的。文件 code.cpp 的单元测试位于 code_tests.cpp 。所有单元测试都是通过调用 pbrt_test 可执行文件来执行的,特定的测试可以通过命令行选项进行选择。

在 pbrt 代码库中有许多断言,其中大多数未包含在书本文本中。这些断言检查在运行时绝不应该为真的条件,如果发现为真,则会发出错误并立即退出。(有关 pbrt 中使用的断言宏的定义,请参见第 B.3.6 节。)失败的断言提供了错误来源的初步线索;像单元测试一样,断言有助于集中调试,至少提供了一个起点。在 pbrt 中一些计算开销较大的断言仅在调试构建中启用;如果渲染器崩溃或以其他方式产生不正确的输出,尝试运行调试构建以查看这些额外的断言是否失败并提供线索是值得的。

我们还努力使在给定像素样本下执行 pbrt 具有确定性。调试渲染器的一大挑战是有些崩溃只在渲染计算几分钟或几小时后发生。通过确定性执行,可以在单个像素样本处重新启动渲染,以更快地返回到崩溃点。此外,在崩溃时, pbrt 将打印一条消息,例如“在 pixel (16, 27) sample 821 处渲染失败。使用 --debugstart 16,27,821 进行调试”。“debugstart”后打印的值取决于所使用的积分器,但足以在接近崩溃的地方重新启动其计算。